PCIe

概述

产品版本

| 芯片名称 | 内核版本 |

|---|---|

| RK1808 | 4.4,4.19 |

| RK3528 | 4.19,5.10,6.1 |

| RK3562 | 5.10,6.1 |

| RK3566/RK3568 | 4.19,5.10,6.1 |

| RK3576 | 6.1 |

| RK3588 | 5.4,5.10,6.1 |

说明:RK3399使用不同的PCIe控制器IP,不在本文档覆盖范围,请参考《Rockchip_RK3399_Developer_Guide_PCIe_CN》。

读者对象

本文档(本指南)主要适用于以下工程师:

- 技术支持工程师

- 软件开发工程师

1. 芯片资源介绍

1.1 RK1808

| 资源 | 模式 | 支持lane | 支持DMA | 支持MMU | 支持ASPM | 备注 |

|---|---|---|---|---|---|---|

| PCIe Gen2 | RC | x2 lane | 否 | 否 | L0s/L1 | 内部时钟 |

1.2 RK3528

| 资源 | 模式 | 支持lane拆分 | 支持DMA | 支持MMU | 支持ASPM | 备注 |

|---|---|---|---|---|---|---|

| PCIe Gen2 x1 | RC | 否 | 否 | 否 | ALL | 内部时钟 |

1.3 RK3562

| 资源 | 模式 | 支持lane拆分 | 支持DMA | 支持MMU | 支持ASPM | 备注 |

|---|---|---|---|---|---|---|

| PCIe Gen2 x1 | RC | 否 | 否 | 否 | ALL | 内部时钟 |

1.4 RK3566

| 资源 | 模式 | 支持lane拆分 | 支持DMA | 支持MMU | 支持ASPM | 备注 |

|---|---|---|---|---|---|---|

| PCIe Gen2 x1 | RC | 否 | 否 | 否 | L0s/L1 | 内部时钟 |

1.5 RK3568

1.5.1 控制器

| 资源 | 模式 | lane拆分 | 支持DMA | 支持MMU | 支持ASPM | 备注 |

|---|---|---|---|---|---|---|

| PCIe Gen2 | RC | 1 lane only | 否 | 否 | L0s/L1 | 内部时钟 |

| PCIe Gen3 | RC/EP | 1 lane RC + 1 lane RC | 2个读Channel + 2个写Channel | 否 | ALL | 支持pcie30phy |

| PCIe Gen3 | RC | 1 lane | 否 | 否 | ALL | 支持pcie30phy |

1.5.2 PHY

| 资源 | dts节点 | 参考时钟 | 拆分 | 是否combo |

|---|---|---|---|---|

| pcie30phy | phy@fe8c0000 | 外部 | 2Lane:默认 | PCIe专用 |

| combphy2_psq | phy@fe840000 | 内部/外部 | 1Lane + 1Lane:rockchip,bifurcation | combo |

说明:pcie30phy 2Lane默认配置为PCIe Gen3 x 2 lane,拆分后“PCIe Gen3 x 2 lane”和“PCIe Gen3 x 1 lane”控制器各1Lane。

1.6 RK3576

| 资源 | 模式 | 支持lane拆分 | 支持DMA | 支持MMU | 支持ASPM | 备注 |

|---|---|---|---|---|---|---|

| PCIe Gen2 x1 | RC | 否 | 否 | 是 | ALL | 内部时钟 |

1.7 RK3588

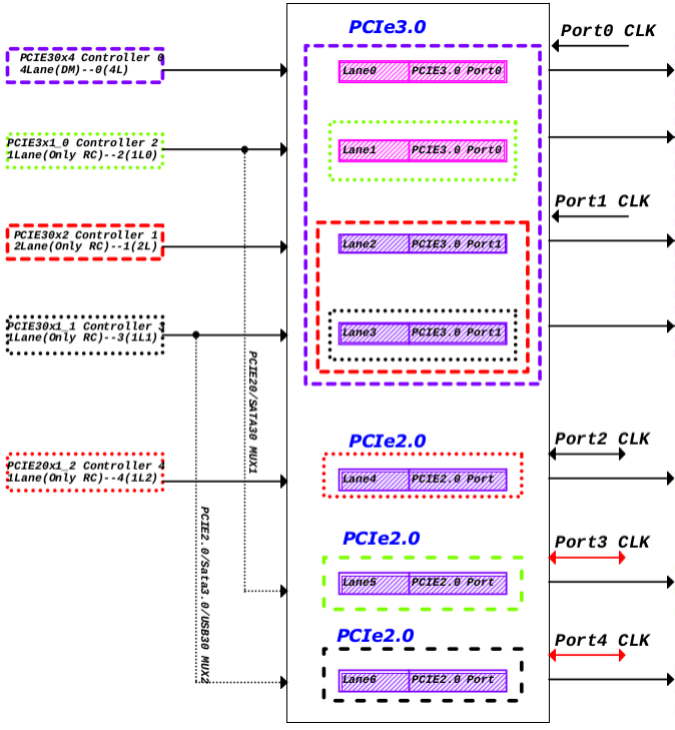

说明: RK3588共有5个PCIe控制器,硬件IP一致,配置不同。其中一个4Lane DM模式可支持作为EP使用,另外2Lane和3个1Lane控制器仅能作为RC使用。 RK3588有两种PCIe PHY,一种为pcie3.0PHY,含2个Port共4个Lane;另一种是pcie2.0 PHY,每个为2.0 1Lane,与SATA和USB combo使用。 pcie3.0 PHY的4Lane可根据需求拆分使用,拆分后需合理配置对应的控制器,所有配置在DTS中完成,无需修改驱动。

使用限制:

- pcie30phy拆分后,pcie30x4控制器,工作于2Lane模式时只能固定配合pcie30phy的port0,工作 于1Lane模式时,只能固定配合pcie30phy的port0lane0;

- pcie30phy拆分后,pcie30x2控制器,工作于2Lane模式时只能固定配合pcie30phy的port1,工作 于1Lane模式时,只能固定配合pcie30phy的port1lane0;

- pcie30phy拆分为4个1Lane,pcie3phy的port0lane1只能固定配合pcie2x1l0控制器,pcie3phy的 port1lane1只能固定配合pcie2x1l1控制器;

- pcie30x4控制器工作于EP模式,可以使用4Lane模式,或者2Lane模式使用pcie30phy的port0, pcie30phy的port1中2lane可以作为RC配合其他控制器使用。默认使用common clock作为 reference clock时,无法实现pcie30phy port0的lane0工作于EP模式,lane1工作于RC模式配合其 他控制器使用,因为Port0的两个lane是共用一个输入的reference clock,RC和EP同时使用clock可 能会有冲突。

- RK3588 pcie30phy 如果只使用其中一个port,另一个port也需要供电,refclk等其他信号可接地。

1.7.1 控制器

| 资源 | 模式 | dts节点 | 可用phy | 内部DMA | 支持ASPM | 支持MMU |

|---|---|---|---|---|---|---|

| PCIe Gen3 x4 | RC/EP | pcie3x4: pcie@fe150000 | pcie30phy | 2个读Channel + 2个写Channel | ALL | 是 |

| PCIe Gen3 x2 | RC | pcie3x2: pcie@fe160000 | pcie30phy | 否 | ALL | 是 |

| PCIe Gen3 x1 | RC | pcie2x1l0: pcie@fe170000 | pcie30phy, combphy1_ps | 否 | ALL | 是 |

| PCIe Gen3 x1 | RC | pcie2x1l1: pcie@fe180000 | pcie30phy, combphy2_psu | 否 | ALL | 是 |

| PCIe Gen3 x1 | RC | pcie2x1l2: pcie@fe190000 | combphy0_ps | 否 | ALL | 是 |

1.7.2 PHY

| 资源 | dts节点 | 参考时钟 | 拆分 | 是否combo |

|---|---|---|---|---|

| pcie30phy | phy@fee80000 | 外部 | 4Lane:PHY_MODE_PCIE_AGGREGATION 2Lane+2Lane:PHY_MODE_PCIE_NANBNB 2Lane+1Lane+1Lane:PHY_MODE_PCIE_NANBBI 1Lane4:PHY_MODE_PCIE_NABIBI | PCIe专用 |

| combphy0_ps | phy@fee00000 | 内部/外部 | - | 与SATA combo |

| combphy1_ps | phy@fee10000 | 内部/外部 | - | 与SATA combo |

| combphy2_psu | phy@fee20000 | 内部/外部 | - | 与SATA/USB3 combo |

1.8 RK3588S

说明:RK3588S的PCIe较为简单,有2个1Lane控制器和2个可用于pcie 2.0的1Lane comboPHY,是一一对应关系。

1.8.1 控制器

| 资源 | 模式 | dts节点 | 可用phy | 内部DMA | 支持ASPM | 支持MMU |

|---|---|---|---|---|---|---|

| PCIe Gen3 x1 | RC | pcie2x1l1: pcie@fe180000 | combphy2_psu | 否 | ALL | 是 |

| PCIe Gen3 x1 | RC | pcie2x1l2: pcie@fe190000 | combphy0_ps | 否 | ALL | 是 |

1.8.2 PHY

| 资源 | dts节点 | 参考时钟 | 拆分 | 是否combo |

|---|---|---|---|---|

| combphy0_ps | phy@fee00000 | 内部/外部 | - | 与SATA combo |

| combphy2_psu | phy@fee20000 | 内部/外部 | - | 与SATA/USB3 combo |

2. DTS 配置

2.1 配置要点

pcie的配置大部分是固定的,需要在板级dts配置的变量并不多,参考以下要点进行配置即可:

- 控制器/PHY使能:根据原理图选择使能正确的控制器和PHY,注意控制器的index和phy的index不一定是顺序匹配的。

- 控制器:部分控制器(如RK3588的pcie2x1l0和pcie2x1l1)有多个phy可选,需按方案设计正确配置“phys”。

- 控制器:作为RC通常需要配置"reset-gpios",对应原理图PCIE的"PERSTn"信��号。

- 控制器:作为RC可能需要配置"vpcie3v3-supply",对应PCIE的"PWREN"gpio信号控制的fixed regulator。

- 控制器:作为EP使用时,需要修改"compatible"为EP模式对应字串。

- PHY:pcie30phy共4个lane,可拆分使用,需根据方案正确配置"rockchip,pcie30-phymode"模式。

2.2 RK1808 DTS配置

RK1808的dts配置,所有的实现模式都在SDK的evb代码中有范例可以参考,可以依照下面表中的模式选 择匹配的内容拷贝到产品板级dts中使用。

| 资源 | 模式 | 参考配置 | 控制器节点 | PHY节点 | 备注 |

|---|---|---|---|---|---|

| PCIe Gen2 x2 lane | RC | rk1808-evb.dtsi | pcie0 | combphy | 需要关闭usbdrd_dwc3和usbdrd3 |

| PCIe Gen2 x2 lane | EP | rk1808-evb.dtsi的pcie0节点 | |||

添加compatible = "rockchip,rk1808-pcie-ep","snps,dw-pcie"; | pcie0 | combphy | 需要关闭usbdrd_dwc3和usbdrd3 |

2.3 RK3528 DTS配置

RK3528的dts配置,所有的实现模式都在SDK的evb代码中有范例可以参考,可以依照下面表中的模式选 择匹配的内容拷贝到产品板级dts中使用

| 资源 | 模式 | 参考配置 | 控制器节点 | PHY节点 |

|---|---|---|---|---|

| PCIe Gen2 x1 lane | RC | rk3528-evb2-ddr3-v10.dtsi | pcie2x1 | combphy_pu |

2.4 RK356X DTS配置

RK356x的dts配置,所有的实现模式都在SDK的evb代码中有范例可以参考,可以依照下面表中的模式选 择匹配的内容拷贝到产品板级dts中使用

2.4.1 RK3562 dts

| 资源 | 模式 | 参考配置 | 控制器节点 | PHY节点 |

|---|---|---|---|---|

| PCIe Gen2 x1 lane | RC | rk3562-evb1-lp4x-v10.dtsi | pcie2x1 | combphy_pu |

2.4.2 RK3566 dts

| 资源 | 模式 | 参考配置 | 控制器节点 | PHY节点 |

|---|---|---|---|---|

| PCIe Gen2 x1 lane | RC | rk3566-evb1-ddr4-v10.dtsi | pcie2x1 | combphy2_psq |

2.4.3 RK3568 dts

| 资源 | 模式 | 参考配置 | 控制器节点 | PHY节点 |

|---|---|---|---|---|

| PCIe Gen2 x1 lane | RC | rk3568-evb2-lp4x-v10.dtsi | pcie2x1 | combphy2_psq |

| PCIe Gen3 x2 lane | RC | rk3568-evb1-ddr4-v10.dtsi | pcie3x2 | pcie30phy |

| PCIe Gen3 拆分1 lane | RC | rk3568-evb6-ddr3-v10.dtsi | pcie3x2 | pcie30phy pcie3x1 |

| PCIe Gen3 x2 lane | EP | rk3568-iotest-ddr3-v10.dts | pcie3x2 | pcie30phy |

2.4.4 RK3576 dts

| 资源 | 模式 | 参考配置 | 控制器节点 | PHY节点 |

|---|---|---|---|---|

| PCIe Gen2 x1 lane | RC | rk3576-test1.dtsi | pcie0 | combphy0_ps |

| PCIe Gen2 x1 lane | RC | rk3576-test1.dtsi | pcie1 | combphy1_psu |

2.5 RK3588 DTS配置

RK3588的控制器和PHY较多,无法在SDK的evb代码中进行穷举所有组合,按配置要点进行配置即可, 这里给出几个典型范例供参考。

2.5.1 示例1 pcie3.0 4Lane RC + 2个pcie 2.0(comboPHY) (RK3588 evb1)

/ {

vcc3v3_pcie30: vcc3v3-pcie30 {

compatible = "regulator-fixed";

regulator-name = "vcc3v3_pcie30";

regulator-min-microvolt = <3300000>;

regulator-max-microvolt = <3300000>;

enable-active-high;

gpios = <&gpio3 RK_PC3 GPIO_ACTIVE_HIGH>;

startup-delay-us = <5000>;

vin-supply = <&vcc12v_dcin>;

};

};

&combphy1_ps {

status = "okay";

};

&combphy2_psu {

status = "okay";

};

&pcie2x1l0 {

phys = <&combphy1_ps PHY_TYPE_PCIE>;

reset-gpios = <&gpio4 RK_PA5 GPIO_ACTIVE_HIGH>;

status = "okay";

};

&pcie2x1l1 {

phys = <&combphy2_psu PHY_TYPE_PCIE>;

reset-gpios = <&gpio4 RK_PA2 GPIO_ACTIVE_HIGH>;

pinctrl-names = "default";

pinctrl-0 = <&rtl8111_isolate>;

status = "okay";

};

&pcie30phy {

rockchip,pcie30-phymode = <PHY_MODE_PCIE_AGGREGATION>;

status = "okay";

};

&pcie3x4 {

reset-gpios = <&gpio4 RK_PB6 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

2.5.2 示例2 pcie3.0phy拆分2个2Lane RC, 3个PCIe 2.0 1Lane(comboPHY)

/ {

vcc3v3_pcie30: vcc3v3-pcie30 {

compatible = "regulator-fixed";

regulator-name = "vcc3v3_pcie30";

regulator-min-microvolt = <3300000>;

regulator-max-microvolt = <3300000>;

enable-active-high;

gpios = <&gpio3 RK_PC3 GPIO_ACTIVE_HIGH>;

startup-delay-us = <5000>;

vin-supply = <&vcc12v_dcin>;

};

};

&combphy0_ps {

status = "okay";

};

&combphy1_ps {

status = "okay";

};

&combphy2_psu {

status = "okay";

};

&pcie2x1l0 {

phys = <&combphy1_ps PHY_TYPE_PCIE>;

reset-gpios = <&gpio4 RK_PA5 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

&pcie2x1l1 {

phys = <&combphy2_psu PHY_TYPE_PCIE>;

reset-gpios = <&gpio4 RK_PA2 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

&pcie2x1l2 {

reset-gpios = <&gpio4 RK_PC1 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

&pcie30phy {

rockchip,pcie30-phymode = <PHY_MODE_PCIE_NANBNB>;

status = "okay";

};

&pcie3x2 {

reset-gpios = <&gpio4 RK_PB0 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

&pcie3x4 {

num-lanes = <2>;

reset-gpios = <&gpio4 RK_PB6 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

2.5.3 示例3 pcie3.0phy拆分为4个1Lane, 1个使用PCIe 2.0 1 Lane(comboPHY)

须知

pcie2x1l0/pcie2x1l1硬件上接入pcie3.0phy对应TX/RX信号,dts关闭combphy1_ps/combphy2_psu节点。

参考代码

/ {

vcc3v3_pcie30: vcc3v3-pcie30 {

compatible = "regulator-fixed";

regulator-name = "vcc3v3_pcie30";

regulator-min-microvolt = <3300000>;

regulator-max-microvolt = <3300000>;

enable-active-high;

gpios = <&gpio3 RK_PC3 GPIO_ACTIVE_HIGH>;

startup-delay-us = <5000>;

vin-supply = <&vcc12v_dcin>;

};

};

&combphy0_ps {

status = "okay";

};

&pcie2x1l0 {

phys = <&pcie30phy>;

reset-gpios = <&gpio4 RK_PA5 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

&pcie2x1l1 {

phys = <&pcie30phy>;

reset-gpios = <&gpio4 RK_PA2 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

&pcie2x1l2 {

reset-gpios = <&gpio4 RK_PC1 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

&pcie30phy {

rockchip,pcie30-phymode = <PHY_MODE_PCIE_NABIBI>;

status = "okay";

};

&pcie3x2 {

num-lanes = <1>;

reset-gpios = <&gpio4 RK_PB0 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

&pcie3x4 {

num-lanes = <1>;

reset-gpios = <&gpio4 RK_PB6 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

status = "okay";

};

2.6 DTS property说明

2.6.1 控制器dts常用配置

-

compatible

- 可选配置项:设置PCIe接口使用的是RC模式还是EP模式。

- RK3568作为RC功能时:

compatible = "rockchip,rk3568-pcie", "snps,dw-pcie"; - RK3568作为EP功能时:

compatible = "rockchip,rk3568-pcie-ep", "snps,dw-pcie"; - RK1808、RK3588:将

rk3568字段分别替换为rk1808和rk3588。

- RK3568作为RC功能时:

- 可选配置项:设置PCIe接口使用的是RC模式还是EP模式。

-

reset-gpios

- 必须配置项:设置PCIe接口的

PERST#复位信号。- 示例:

reset-gpios = <&gpio3 13 GPIO_ACTIVE_HIGH>; - 注意:如果将多个lane的PCIe接口拆分,每个节点需配置不同的

PERST#信号线。

- 示例:

- 必须配置项:设置PCIe接口的

-

num-lanes

- 可选配置项:设置PCIe设备所使用的lane数量。

- 示例:

num-lanes = <4>; - 默认配置在芯片级的dtsi中,建议按实际硬件配置。

- 示例:

- 可选配置项:设置PCIe设备所使用的lane数量。

-

max-link-speed

- 可选配置项:设置PCIe的带宽版本。

- 1表示Gen1,2表示Gen2,3表示Gen3。

- 示例:

max-link-speed = <2>; - 原则上不需要每个板子配置,仅作为测试或降级手段。

- 可选配置项:设置PCIe的带宽版本。

-

status

- 必须配置项:在PCIe控制器节点和对应的phy节点中同时使能。

- 示例:

status = "okay";

- 示例:

- 必须配置项:在PCIe控制器节点和对应的phy节点中同时使能。

-

vpcie3v3-supply

- 可选配置项:用于配置 PCIe 外设的 3V3 供电(原则上我司的硬件参考原理图上将PCIe插槽的12V电源和 3V3电源合并控制,所以配置3v3的电源之后,12V电源一并控制)。如果板级针对 PCIe 外设的 3V3 需要 控制使能,则如范例所示定义一组对应的 regulator,regulator 的配置请参考 Documentation/devicetree/bindings/regulator/。 另需要特别注意,如果是PCIe3.0的控制器,一般需要外接100M晶振芯片,那么该晶振芯片的供电原则 上硬件设计与PCIe外设的3V3共用。所以配置了该项之后,除了确认外设3V3供电之外,还需要确认外置 晶振芯片的时钟是否输出正常。一般而言,外置晶振芯片需要一个稳定周期来输出时钟。因此请严格参 考时钟芯片的手册中规定的最小数值,并在留有测试余量的基础上,在电源节点中指定startup-delay-us 属性的数值。另外针对关闭电源后放电较慢的硬件设计,在电源节点中指定 off-on-delay-us属性的数 值,保证上下电操作充分。以rk3568为例,详细范例可参考rk3568-evb1-ddr4-v10.dtsi文件中的 vcc3v3_pcie节点。

-

phys

- 可选配置项:用于配置控制器使用的phy的phandle引用,部分控制器可以路由到多个phy(如RK3588的

pcie2x1l0和pcie2x1l1),需要注意的是不同的phy引用方式可能有差异,comboPHY需要同时指定phy的

工作模式,具体如下:

- 示例:

phys = <&pcie30phy>;

phys = <&combphy1_ps PHY_TYPE_PCIE>;

- 示例:

- 可选配置项:用于配置控制器使用的phy的phandle引用,部分控制器可以路由到多个phy(如RK3588的

pcie2x1l0和pcie2x1l1),需要注意的是不同的phy引用方式可能有差异,comboPHY需要同时指定phy的

工作模式,具体如下:

-

rockchip,bifurcation

- 可选配置项:此为RK3568芯片特有配置。可以将pcie3x2的2个lane 拆成两个1个lane的控制器来使用。 具体的配置方法就是dts中pcie3x1和pcie3x2控制器节点和pcie30phy都使能,并且pcie3x2和pcie3x1节 点中都添加rockchip,bifurcation属性。可参考rk3568-evb6-ddr3-v10.dtsi。否则默认情况下,pcie3x1 控制器无法使用。

此时lane0是由pcie3x2控制器使用,lane1是由pcie3x1控制器使用,硬件布板上严格按照我司原理图。 另注意,此模式下两个1-lane的控制器必须同时工作在RC模式下。

另外需要特别注意,PCIe 3.0拆分成2个单lane后接两个不同外设,由于晶振及其电源是同一路控制。此 时请不要将vpcie3v3-supply配置给其中某一个控制器,否则会造成获取了3v3电压操作权限的这路控制 器干扰另一控制器所接的外设的正常初始化。此时应该将vpcie3v3-supply所对应的regulator配置成 regulator-boot-on和regulator-always-on

-

prsnt-gpios = <&gpio4 15 GPIO_ACTIVE_LOW>;

- 可选配置项:用于驱动识别是否存在外设以及相关外围电路,若检测到有效电平则跳过设备检测流程 。 根据PCIe电气化特性协议文档,此gpio为低电平时候表示有设备接入。若板子设计与此相反,可修改为 GPIO_ACTIVE_HIGH来标识高电平为有设备接入。该信号用于同套软件支持相同板型带PCIe3的产品和 不带PCIe3的产品,避免pcie控制器初始化时发生rcu stall的系统异常;

rockchip,perst-inactive-ms = <500>;

- 可选配置项:可选配置项:用于配置设备#PERST复位信号的复位时间,单位为毫秒。根据PCIe Express Card Electromechanical Spec要求,下游设备电源稳定到释放#PERST最小需求为100ms,不配置此项则RK 驱动默认配置了200ms。若仍不满足外设工作要求,可以酌情调整,以实测为准。

rockchip,s2r-perst-inactive-ms = <1>;

- 可选配置项:用于配置休眠唤醒时设备#PERST复位信号的复位时间,单位为毫秒。若不配置,它的数值 等同于 rockchip,perst-inactive-ms 的配置。如果外设在休眠期间不断电,以Wi-Fi为例,则休眠过程 中#PERST一直处于复位状态,因此唤醒过程中可以缩短#PERST复位信号的时间,甚至可以配置成0。

rockchip,wait-for-link-ms = <1>;

- 可选配置项:可选配置项:用于配置设备#PERST复位信号释放后的等待时间,单位为毫秒。此配置用于部分需要较长 时间进行内部初始化的外设,防止因其内部初始化较久而使得系统等待链接超时的情况发生。目前常见 的需要此配置的是FPGA和部分AI算力卡。

- supports-clkreq

- 可选配置项:仅在 RC mode 下有效,请确认已配置 CLKREQ# pinctrl iomux 为 function io 后,如果存 在此属性,则指定存在从root port到下游设备的CLKREQ#信号路由,并且主机网桥驱动程序可以根据 CLKREQ#信号的存在进行编程,例如,如果没有CLKREQ#信号,则将root port设置为不支持PM L1 Substates。

- rockchip,lpbk-master

- 特殊调试配置:此配置是针对loopback信号测试,使用PCIe控制器构造模拟loopback master环境,让 待测试对端设备进入slave模型,非模拟验证实验室的RX环路需求请勿配置。另注意,Gen3控制器可能 需要配置compliance模式,才可以loopback slave模式。如果阅读者不理解什么是loopback测试,说明 这不是你要找的配置,请勿针对此配置提问。

- rockchip,compliance-mode

- 特殊调试配置:此配置是针对compliance信号测试,使PCIe控制器强制进入compliance测试模式或者

当使用SMA夹具进入测试模式后不断电。这是一个包含两个配置的数组,数组的第一个配置表示测试模

式,第二个配置表示在前述配置下的preset数值。如果使用SMA夹具测试,建议配置

rockchip,compliance-mode=<0 0>;;如果测试焊接设备,需要固定配置模式和preset数值,rockchip,compliance-mode=<mode preset>;。mode根据需要配置成1、2或者3,分别代表 2.5GT、5.0GT和8GT信号。仅在5GT和8GT模式下,preset的有效数值为0到10,分别代表P0到P10不同 的协议预加重等配置,可参考附录中“关于PCIe TX加重预设值对照表”的部分。

- rockchip,keep-power-in-suspend

- 可选配置项:仅在 RC mode 下有效,用于实现在休眠状态下不关闭外设的电源和对其进行复位。允许外

设在系统休眠后脱机工作。此模式生效还需要pcie节点引用

vpcie3v3-supply。

2.6.2 comboPHY dts配置

- 以下配置不适用于RK1808的combphy节点。

combphy节点数字表示Mux�关系,后缀表示复用关系,p、s、u、q分别表示PCIe、SATA、USB、QSGMII。

- rockchip,ext-refclk

-

特殊调试配置:首先请注意此配置仅仅针对combophy。默认combphy使用SoC内部时钟方案,以 RK356X为例,可参阅rk3568.dtsi节点,默认使用24MHz时钟源。除了24MHz时钟源,还支持25M和 100M,仅需要调整

assigned-clock-rates = <24000000>数值为所需频率即可。内部时钟源方案成本最 优,所以作为SDK默认方案,但combphy仍然预留了外部晶振芯片的时钟源输入选择。如果确实需要使 用外部时钟晶振芯片提供时钟的方案,请在板级dts的PCIe控制器用的combphy节点中加入 rockchip,ext-refclk,且需要注意在节点中加入assigned-clock-rates = <时钟频率>来指定外部时钟芯片 输入的频率,仍然只支持24M,25M,100M三档。- rockchip,enable-ssc

- 特殊调试配置:首先请注意此配置仅仅针对PCIe所使用的combphy结点。默认情况下,combophy输出 时钟不开启展频。如果用户需要规避一些EMI问题,可尝试在对应的combphy节点加入此配置项,开启 SSC。

2.6.3 pcie30phy dts配置

- rockchip,pcie30-phymode

- 可选配置项:该配置为pcie30phy的组合使用模式,需要合理配置,默认为4Lane共用。详细的可选内容

参考

include/dt-bindings/phy/phy-snps-pcie3.h:

- 可选配置项:该配置为pcie30phy的组合使用模式,需要合理配置,默认为4Lane共用。详细的可选内容

参考

/*

* pcie30_phy_mode[2:0]

* bit2: aggregation

* bit1: bifurcation for port 1

* bit0: bifurcation for port 0

*/

#define PHY_MODE_PCIE_AGGREGATION 4 /* PCIe3x4 */

#define PHY_MODE_PCIE_NANBNB 0 /* P1:PCIe3x2 + P0:PCIe3x2 */

#define PHY_MODE_PCIE_NANBBI 1 /* P1:PCIe3x2 + P0:PCIe3x1*2 */

#define PHY_MODE_PCIE_NABINB 2 /* P1:PCIe3x1*2 + P0:PCIe3x2 */

#define PHY_MODE_PCIE_NABIBI 3 /* P1:PCIe3x1*2 + P0:PCIe3x1*2 */

2.7 根据原理图填写DTS

2.7.1 低速IO说明

PCIe模块的芯片信号连接,除了数据线和参考时钟差分对,可能还有以下这些低速IO:

低速IO名 RC模式 EP模式 说明 PERSTn GPIO输出 接nPOR 必选,配置dts "reset-gpios"项WAKE GPIO(PMU域) GPIO输出 可选,function驱动注册对应GPIO中断及唤醒源,非PCIe控制器驱动处理 PWREN GPIO输出 无 可选,配置dts "vpcie3v3-supply"项CLKREQ FUNCTION FUNCTION 可选,支持L1SS时使用,配置dts "supports-clkreq"项PRSNT GPIO输入 无 可选,配置dts "prsnt-gpios"项- 其中只有

CLKREQ使用PCIe的function功能,该信号仅L1SS功能需要使用,否则可以不接,使用时必须添加dts对应属性。 - 其他信号都是使用GPIO功能,请勿在pinctrl里面配置为pcie function,具体用法请参考dts对应配置说明。

PERST信号是协议要求的必选信号,其他信号根�据实际项目需求进行配置。

2.7.2 dts配置方法

原理图是基于IO信号的视角来描述硬件,IO信号是跟PHY的index强相关的,而RK3588的controller和PHY的index可能不一致,因此在查看原理图时需要特别注意这一点。

根据硬件原理图来填写dts的建议步骤:

- 确认PCIe设备分配:

- 跟硬件工程师确认使用了几个PCIe设备,芯片的多个PCIe接口是如何分配的。

- 查找PHY输出:

- 在原理图中分别查找某个设备使用的PCIe数据线对应到哪个PHY的输出。

- 确定控制器和PHY:

- 确定当前设备使用的分别是哪个控制器和PHY,在dts中使能。

- 检查控制器的

phy属性:- 确定当前PCIe接口使用的控制器dts

"phy"属性及模式是否选择正确,例如pcie2x1ln控制器需要选择comboPHY且指定为PHY_TYPE_PCIE。

- 确定当前PCIe接口使用的控制器dts

- 禁用其他控制器:

- 如果

comboPHY可能被SATA、USB、RGMII等多个控制器共用,请确认对应的其他控制器在dts中被disable。

- 如果

- 配置PHY模式:

- 确定当前PHY是否有多种工作模式,配置是否正确,例如

pcie30phy的不同拆分组合需要正确配置对应模式。

- 确定当前PHY是否有多种工作模式,配置是否正确,例如

- 配置

PERSTn信号:- 确定当前PCIe接口使用的

PERSTn信号是哪个GPIO,正确配置到控��制器dts节点。

- 确定当前PCIe接口使用的

- 配置

PWREN信号:- 确定当前PCIe接口使用的

PWREN信号是哪个GPIO控制的,正确配置到控制器dts节点(也可以放到on board外设的dts中)。

- 确定当前PCIe接口使用的

- 配置其他外设硬件:

- 配置其他外设工作所需的硬件。

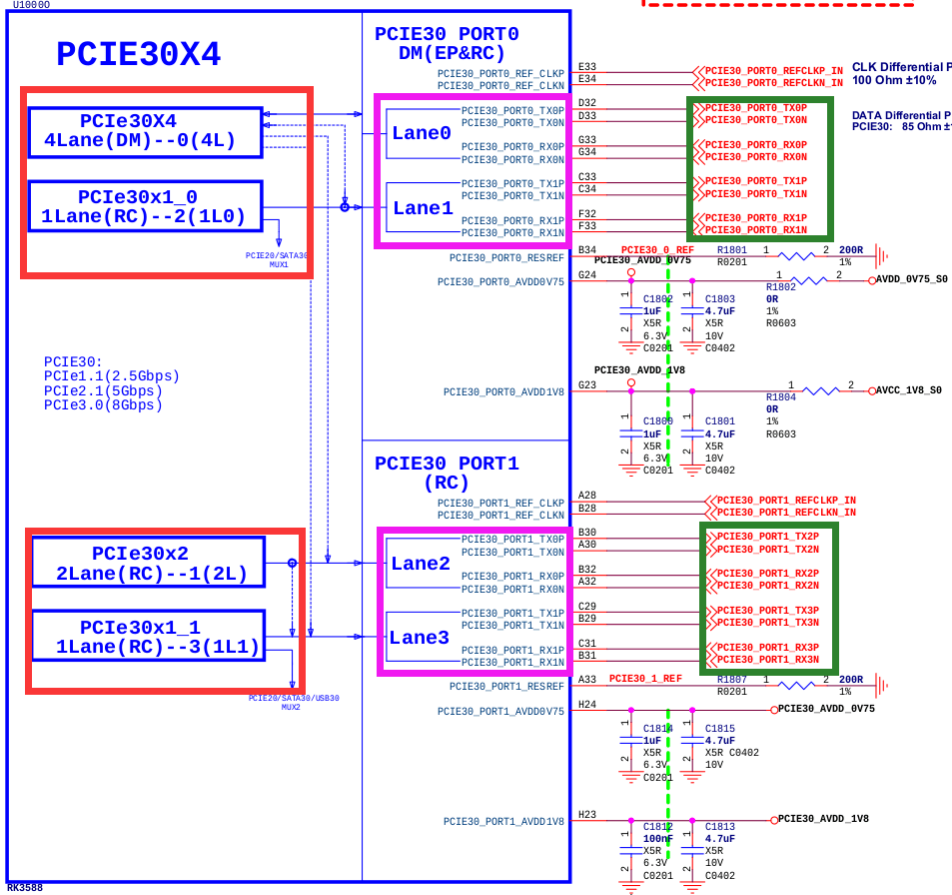

下图是RK3588 pcie30phy及其可能使用的controller,红色方框为controller,粉色方框为PHY信号,绿 色方框为外设信号;实际使用哪个控制器可以通过外设信号连接来确认,也可以跟硬件工程师核对理解 是否正确。下图是来自RK3588 evb1, 设备接的是一个pcie3.0 x4的slot,所以controller用的是 PCIe30X4(dts命名pcie3x4),其他几个controller都未跟这个PHY配合使用。

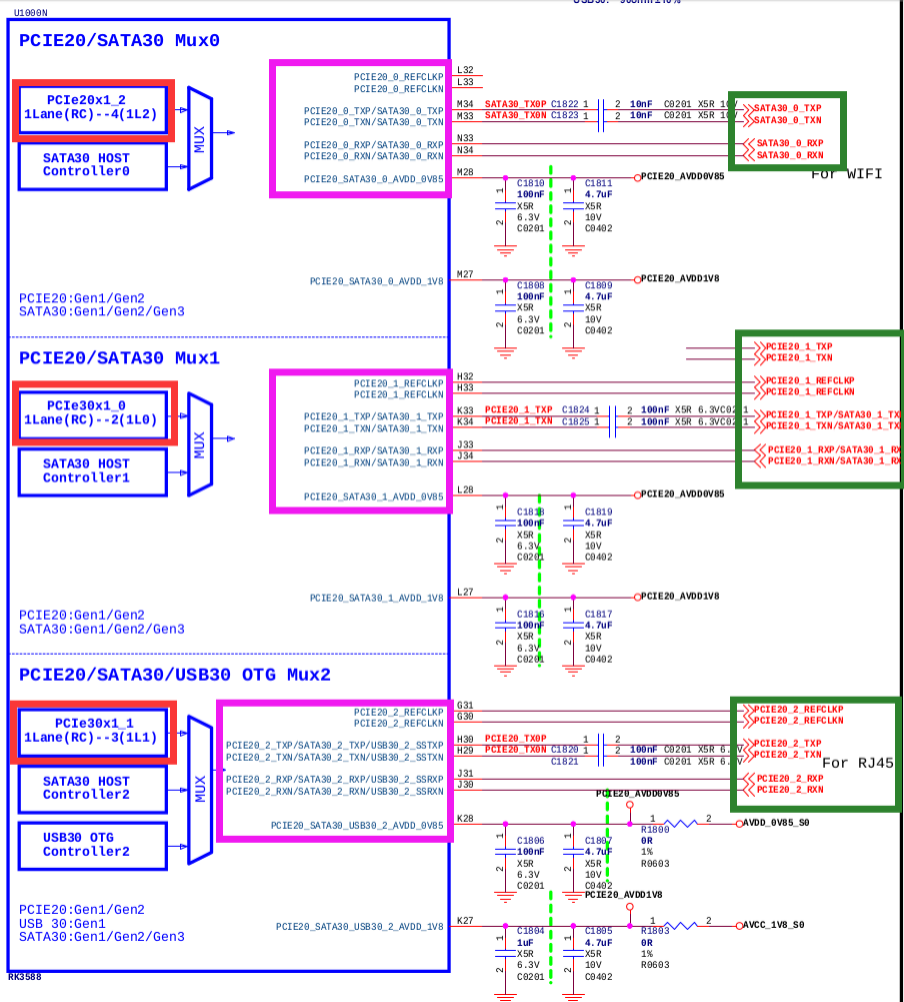

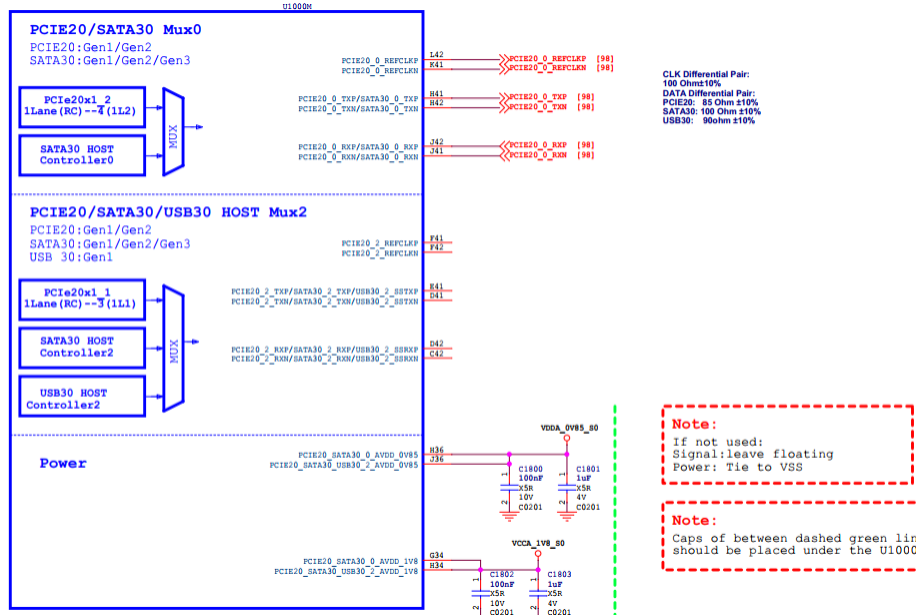

下图是RK3588 comboPHY及其可能使用的controller,红色方框为controller,粉色方框为PHY信号, 绿色方框为外设信号;实际使用哪个控制器可以通过外设信号连接来确认,也可以跟硬件工程师核对理 解是否正确。此图中Mux0的PHY(combphy0_ps)工作于SATA模式,未工作于PCIe;Mux1的 PHY(combphy1_ps)配合PCIe30x1_0(dts命名为pcie2x1l0)可能工作于PCIe模式,需要由最终实际接的 设备来确定;Mux2的PHY(combphy2_psu)配合PCIe30x1_1(dts命名为pcie2x1l1)工作于pcie模式用于 连接一个PCIe网卡。

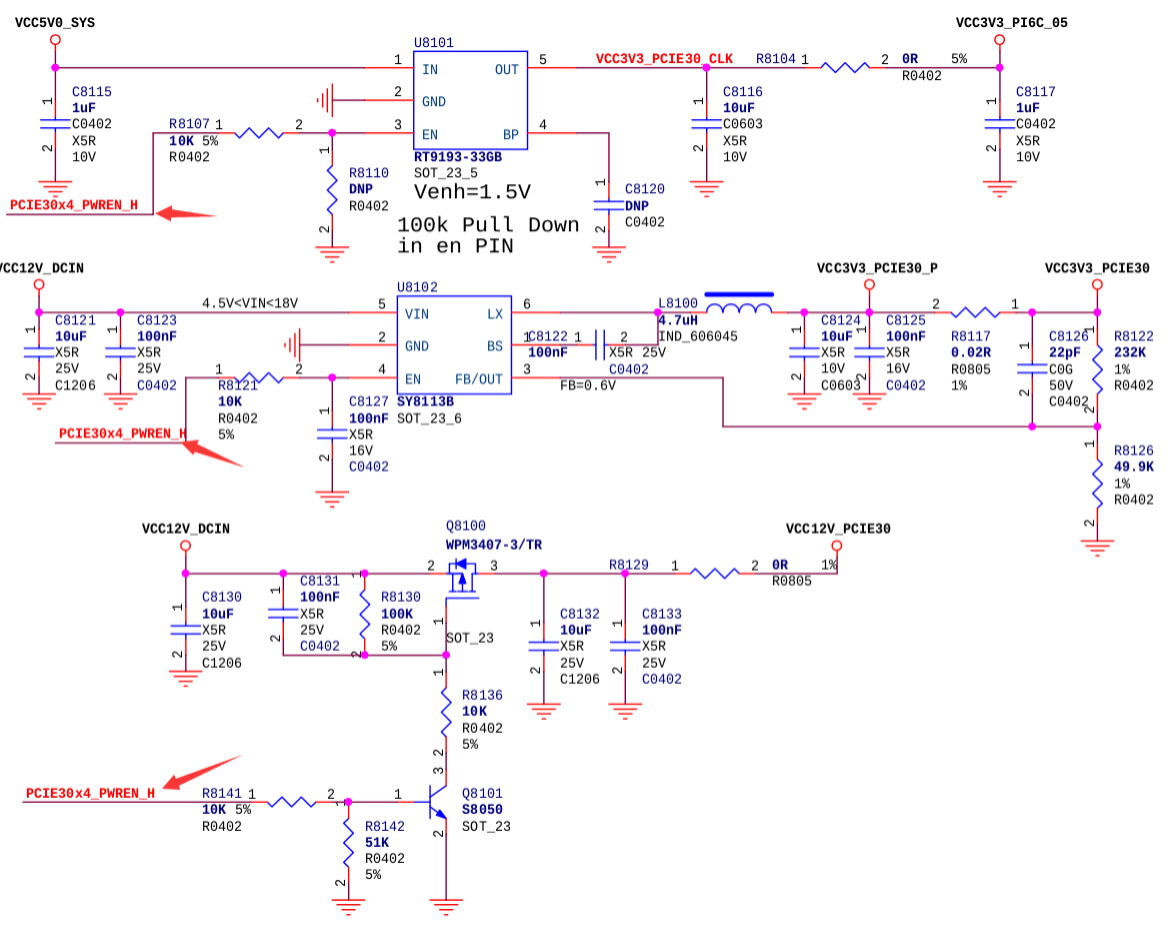

下图为RK3588 evb1的pcie3.0接口供电,可以通过PCIE30X4_PWREN_H这个信号来定位对应的RK3588 GPIO,然后填到pcie3x4控制器dts中。

2.8 Wi-Fi模块设备树编写范例

由于Wi-Fi模块一般接入PCIe2.0口,其使用的

combphy复用关系复杂,且其电源使用方式、休眠模式、复位需求与其他设备有明显的不同,此处给出一个设备树编写范例,请酌情参考。- 查看原理图,弄清楚Wi-Fi模块所使用的combphy。combphy节点数字表示Mux关系,后缀表示复

用关系,p、s、u、q分别表示PCIe、SATA、USB、 QSGMII。以此图为例,Wi-FI是接到了PCIe与

SATA复用的

PCIE20/SATA30 Mux0上,因此配置的应该是combphy0_ps节点。

- 搜索dts文件,确保复用此combphy功能的其他控制器节点关闭,防止信号干扰。

- 将wifi_reg_on信号从wireless_wlan节点挪到PCIe 3.3v电源控制节点中。

- 如果Wi-Fi需要实现L1.x功耗模式,请参考”RC mode PM L1 Substates 支持“章节。

- 如果Wi-Fi需要实现无线唤醒功能,需要确保 wifi_reg_on管脚在休眠时保持高电平, wifi_host_wake管脚连接到不断电的PMU IO上用于产生中断唤醒主控,具体硬件接发和软件修改 详述请参考我司SDK发布文档中的《Rockchip_Developer_Guide_Linux_WIFI_BT_CN.pdf》相关章 节。

- rockchip,enable-ssc

-

+ vcc3v3_pcie20_wifi: vcc3v3-pcie20-wifi {

+ compatible = "regulator-fixed";

+ regulator-name = "vcc3v3_pcie20_wifi";

+ regulator-min-microvolt = <3300000>;

+ regulator-max-microvolt = <3300000>;

+ enable-active-high;

+ /*

+ * wifi_reg_on 是在vbat、vddio稳定后才使能,在reset-gpios前拉高,所以

+ * 放到PCIe的电源节点中才满足模块时序,引用wifi_poweren_gpio。

+ */

+ pinctrl-0 = <&wifi_poweren_gpio>;

+ startup-delay-us = <5000>;

+ vin-supply = <&vcc12v_dcin>;

+ };

wireless_wlan: wireless-wlan {

compatible = "wlan-platdata";

wifi_chip_type = "ap6275p";

pinctrl-names = "default";

pinctrl-0 = <&wifi_host_wake_irq>;

WIFI,host_wake_irq = <&gpio0 RK_PA0 GPIO_ACTIVE_HIGH>;

+ /* 注意:这里也需要配置wifi_reg_on管脚,给WiFi驱动来控制 */

+ WIFI,poweren_gpio = <&gpio0 RK_PC7 GPIO_ACTIVE_HIGH>;

status = "okay";

};

+

+&sata0 {

+ status = "disabled" /* sata0与pcie2x1l2复用了combphy0_ps, 需确保禁用 */

+}

+

+&combphy0_ps {

+ status = "okay"; /* 确保phy开启 */

+};

+

+&pcie2x1l2 {

+ reset-gpios = <&gpio3 RK_PD1 GPIO_ACTIVE_HIGH>;

+ rockchip,skip-scan-in-resume;

+ rockchip,perst-inactive-ms = <500>; /* 参考Wi-Fi模组手册,查询所需#PERST复位时间

*/

+ vpcie3v3-supply = <&vcc3v3_pcie20_wifi>;

+ status = "okay";

+};

&pinctrl {

wireless-wlan {

wifi_poweren_gpio: wifi-poweren-gpio {

+ //PCIE REG ON: 务必配置成上拉

+ rockchip,pins = <0 RK_PC7 RK_FUNC_GPIO &pcfg_pull_up>;

};

};

};

3. menuconfig 配置

- 需要确保如下配置打开,方可正确的使用 PCIe 相关功能

CONFIG_PCI=y

CONFIG_PCI_DOMAINS=y

CONFIG_PCI_DOMAINS_GENERIC=y

CONFIG_PCI_SYSCALL=y

CONFIG_PCI_BUS_ADDR_T_64BIT=y

CONFIG_PCI_MSI=y

CONFIG_PCI_MSI_IRQ_DOMAIN=y

CONFIG_PHY_ROCKCHIP_SNPS_PCIE3=y

CONFIG_PHY_ROCKCHIP_NANENG_COMBO_PHY=y

CONFIG_PCIE_DW=y

CONFIG_PCIE_DW_HOST=y

CONFIG_PCIE_DW_ROCKCHIP=y

CONFIG_PCIEPORTBUS=y

CONFIG_PCIE_PME=y

CONFIG_GENERIC_MSI_IRQ=y

CONFIG_GENERIC_MSI_IRQ_DOMAIN=y

CONFIG_IRQ_DOMAIN=y

CONFIG_IRQ_DOMAIN_HIERARCHY=y

- 使能 NVMe 设备(建立在 PCIe 接口的 SSD),PCIe转接AHCI设备(SATA),PCIe转接USB设备(XHCI) 均已在默认config中打开,烦请确认。其他转接设备例如以太网卡,WiFi等请自行确认相关config配置。

CONFIG_BLK_DEV_NVME=y

CONFIG_SATA_PMP=y

CONFIG_SATA_AHCI=y

CONFIG_SATA_AHCI_PLATFORM=y

CONFIG_ATA_SFF=y

CONFIG_ATA=y

CONFIG_USB_XHCI_PCI=y

CONFIG_USB_XHCI_HCD=y

特别说明,默认内核仅支持 drivers/ata/ahci.c 中列表内的PCIe转接SATA设备,超出部分请找原厂或者代理商支持。

4. 标准EP功能件开发

RK部分芯片的PCIe控制器支持EP模式,可以将芯片开发为标准PCIe EP产品,针对EP功能的实现,请参考文档《Rockchip_Developer_Guide_PCIE_EP_Stardard_Card_CN》。

5. RC mode PM L1 Substates 支持

当确认所用 RK 主控及所接的外设都支持 PCIe PM L1 Substates,可以通过开启 PM L1 Substates 功能支持对功耗进一步优化。

进一步强调,如果目标外设中有不支持 PM L1 Substates 的设备,尤其是主板设计为 slot 外接非固定器件,请勿开启 PM L1 Substates 功能,否则部分设备将无法正常工作。

PM L1 Substates 支持的硬�件电路设计

RC CLKREQ#、EP CLKREQ# 双端互联

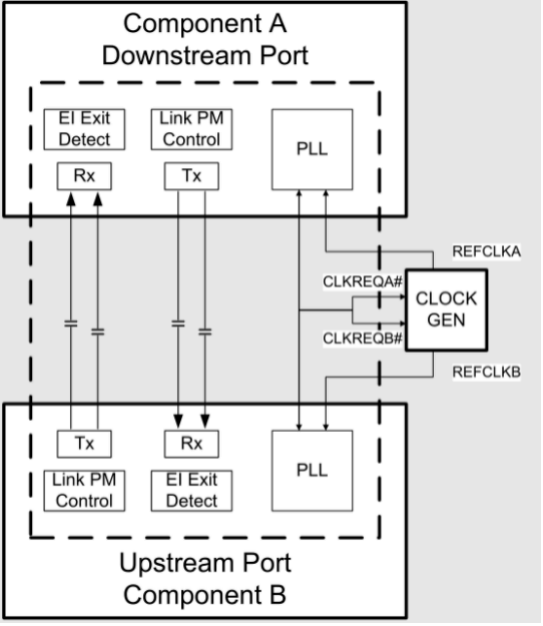

可选优化: 外部参考时钟方案,可以考虑 CLKREQ# 接入 CLOCK_GEN OE,如 CLOCK_GEN OE 为高有效,则应添加反相器

系统默认设置

关闭系统对 PM L1 Substates 支持:

- dts 未添加

supports-clkreq;属性 - 内核宏配置

CONFIG_PCIEASPM_POWER_SUPERSAVE=n

系统开启 PM L1 Substates 支持

- 确认 RC/EP 都支持 PM L1 Substates,其中RC的支持情况可查阅“芯片资源介绍”章节之ASPM一栏。

- 硬件配置 CLKREQ# 信号:确认符合 “PM L1 Substates 支持的硬件电路设计”

- 软件配置 CLKREQ# 信号:设置 CLKREQ# iomux 为 function io

- 软件配置控制器节点添加

supports-clkreq;属性,详细参考 "dts 可配置项 11" 说明 - 开启 PM L1 Substates 支持:

- 方法1:内核宏配置

CONFIG_PCIEASPM_POWER_SUPERSAVE=y - 方法2:部分外设如 WIFI,支持驱动中使能 PM L1 Substates

- 方法1:内核宏配置

说明:

- 如果不严格符合以上条件却要尝试通过开启内核宏配置,PCIe link 可能会进入异常状态,无法唤醒

- 请确认内核源码为较新代码,包含支持 L1SS 补丁:commit e18dfa93 PCI: rockchip: dw: Support PM L1 clock removing

6. 基于GPIO方式的拔插检测机制

6.1 硬件要求

- PCIe slot的PRSNT#_1需要与主控的任意GPIO相连,作为检测脚

- PCIe设备的电源需要软件可控制上下电

6.2 软件要求

- 至少包含以下提交,如无请联系业务获取补丁:

commit 4de1a0c19e0f9804ba22e7f5e544fea317913957

Author: Shawn Lin <shawn.lin@rock-chips.com>

Date: Tue Mar 12 16:38:46 2024 +0800

PCI: rockchip: dw: Add gpio based hotplug

Change-Id: I49c57755d11cc43bbf7cf9eb23542f5e1e11aaa3

commit 86f3010d7f523c9f5a2e88d9f8f1871ed89da098

Author: Vidya Sagar <vidyas@nvidia.com>

Date: Sat Oct 1 00:57:45 2022 +0530

FROMLIST: PCI/hotplug: Add GPIO PCIe hotplug driver

Change-Id: Iafa798ee4d98f195f5d33d80120da0c569132548

- 内核需确认打开如下配置:

CONFIG_HOTPLUG_PCI=y

CONFIG_HOTPLUG_PCI_GPIO=y

- DTS配置参考如下

&pcie0 {

reset-gpios = <&gpio4 RK_PC7 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie0>;

hotplug-gpios = <&gpio4 RK_PC4 IRQ_TYPE_EDGE_BOTH>;

pinctrl-names = "default";

pinctrl-0 = <&hot_plug0>;

status = "okay";

};

&pinctrl {

pcie {

hot_plug0: hot-plug0 {

rockchip,pins = <4 RK_PC4 RK_FUNC_GPIO &pcfg_pull_up>;

};

};

};

6.3 使用限制

- PCIe设备带电拔插极易损坏设备和主控,在设备拔出后的卸载流程和断电流程需要一点时间,所以禁止快速热拔插。需要等到如下移除log后,再重新插入:

[ 35.680289][ T134] pcieport 0000:00:00.0: Hot-UnPlug Event

[ 35.680361][ T134] pcieport 0000:00:00.0: Power Status = 1

[ 35.827183][ T134] rk-pcie 2a200000.pcie: rk_pcie_slot_disable

[ 35.827303][ T134] pcieport 0000:00:00.0: Hot-UnPlug Event

[ 35.827323][ T134] pcieport 0000:00:00.0: Power Status = 0

[ 35.827334][ T134] pcieport 0000:00:00.0: Device is already removed

-

为保证数据的完整性和系统的稳定性,需要确保系统停止访问待拔出设备。

-

无法支持switch下游设备的单独拔插。如有此需求,首先需要确认switch支持下游设备打单独热拔插,然后参考常见应用问题中“如何对下游单个设备进行重扫描或者在线更换设备?”部分进行rescan处理,亦可达到同等效果。

-

不支持在休眠待机状态下,检测插入或者移除设备。

7. 内核 DMATEST

在进行开发前请确认目标PCIe控制器是否支持DMA传输,详细参考“芯片资源介绍”章节。

RK PCIe DMA提供基于内核module_para机制的测试机制,框架类似Linux dmatest,可以基于该框架进一步完成内核下的PCIe DMA应用。

内核版本要求

至少包含以下提交,如无请联系业务获取补丁:

commit a7c40cb119703e566d9d5befb8c1a7b0533dd7b7

Author: Jon Lin <jon.lin@rock-chips.com>

Date: Tue Jan 17 17:46:48 2023 +0800

PCI: rockchip: dw-dmatest: Suppport rc dma

1.Set rc dma as default

2.Changet to ep dma by sending command:

echo 0 > ./sys/module/pcie_dw_dmatest/parameters/is_rc

Change-Id: I9b16c328c08f220772e487c7c796b8898d74ae10

Signed-off-by: Jon Lin <jon.lin@rock-chips.com>

测试宏配置

CONFIG_PCIE_DW_DMATEST=y

CONFIG_ROCKCHIP_PCIE_DMA_OBJ=n

搭建环境

PCIe 互联模型:

- 客户自行搭建RK RC - FPGA EP环境

- RK本地测试搭建为RK RC(RK dmatest 配置)-RK EP(RK 芯片互联配置)

注意:

- MPS 配置为 256B

- RC EP都需要reserved memory,建议在0x3c000000预留64MB测试用内存(测试默认配置的地址)

- 建议关闭其他无关的 PCIe 控制器

测试

详细参考:pcie-dw-misc-dmatest.c源码

static int size = 0x20;

module_param(size, int, 0644);

MODULE_PARM_DESC(size, "each packet size in bytes");

static unsigned int cycles_count = 1;

module_param(cycles_count, uint, 0644);

MODULE_PARM_DESC(cycles_count, "how many erase cycles to do (default 1)");

static bool irq;

module_param(irq, bool, 0644);

MODULE_PARM_DESC(irq, "Using irq? (default: false)");

static unsigned int chn_en = 1;

module_param(chn_en, uint, 0644);

MODULE_PARM_DESC(chn_en, "Each bits for one dma channel, up to 2 channels, (default enable chanel 0)");

static unsigned int rw_test = 3;

module_param(rw_test, uint, 0644);

MODULE_PARM_DESC(rw_test, "Read/Write test, 1-read 2-write 3-both(default 3)");

static unsigned int bus_addr = 0x3c000000;

module_param(bus_addr, uint, 0644);

MODULE_PARM_DESC(bus_addr, "Dmatest chn0 bus_addr(remote), chn1 add offset 0x100000, (default 0x3c000000)");

static unsigned int local_addr = 0x3c000000;

module_param(local_addr, uint, 0644);

MODULE_PARM_DESC(local_addr, "Dmatest chn0 local_addr(local), chn1 add offset 0x100000, (default 0x3c000000)");

static unsigned int test_dev;

module_param(test_dev, uint, 0644);

MODULE_PARM_DESC(test_dev, "Choose dma_obj device,(default 0)");

static bool is_rc = true;

module_param_named(is_rc, is_rc, bool, 0644);

MODULE_PARM_DESC(is_rc, "Test port is rc(default true)");

实例参考1:RC设备,channel 0,写数据,数据粒度1MB,循环次数1000,local 地址0x3c000000,remote地址0x3c000000:

echo 0 > ./sys/module/pcie_dw_dmatest/parameters/test_dev

echo 1 > ./sys/module/pcie_dw_dmatest/parameters/is_rc

echo 1 > ./sys/module/pcie_dw_dmatest/parameters/chn_en

echo 1 > ./sys/module/pcie_dw_dmatest/parameters/rw_test

echo 0x100000 > ./sys/module/pcie_dw_dmatest/parameters/size

echo 1000 > ./sys/module/pcie_dw_dmatest/parameters/cycles_count

echo 0x3c000000 > ./sys/module/pcie_dw_dmatest/parameters/local_addr

echo 0x3c000000 > ./sys/module/pcie_dw_dmatest/parameters/bus_addr

echo run > ./sys/module/pcie_dw_dmatest/parameters/dmatest

实例参考2:EP设备,channel 0/1(双线程同时运行),读写数据,数据粒度8KB,循环次数10000,local 地址 0x3c000000,remote 地址 0x3c000000:

echo 0 > ./sys/module/pcie_dw_dmatest/parameters/test_dev

echo 0 > ./sys/module/pcie_dw_dmatest/parameters/is_rc

echo 3 > ./sys/module/pcie_dw_dmatest/parameters/chn_en

echo 3 > ./sys/module/pcie_dw_dmatest/parameters/rw_test

echo 0x2000 > ./sys/module/pcie_dw_dmatest/parameters/size

echo 10000 > ./sys/module/pcie_dw_dmatest/parameters/cycles_count

echo 0x3c000000 > ./sys/module/pcie_dw_dmatest/parameters/local_addr

echo 0x3c000000 > ./sys/module/pcie_dw_dmatest/parameters/bus_addr

echo run > ./sys/module/pcie_dw_dmatest/parameters/dmatest

8. 内核 稳定性统计信息

PCIe 设备长期工作状态下出现异常,其运行状态不符合预期,可以尝试获取debugfs节点中的信息以便提供给我们进行分析。若需要启用此功能,先确保包含此提交(pcie: rockchip: dw: Add debugfs support),否则可以在附录章节所示redmine系统中获取0001-pcie-rockchip-dw-Add-debugfs-support.patch。

使用方法

- 明确出问题的设备所处的控制器地址节点,可从开机枚举log中查阅或者直接从dtsi中查看。

- 以fe16000.pcie 为例, 进入

/sys/kernel/debug/fe160000.pcie目录 echo disable > err_event关闭所有的事件统计功能echo clear > err_event清除所有的事件统计计数echo enable > err_event开启所有的事件统计功能- 开始设备老化,复现您的异常case, 复现后请执行

cat dumpfifo和cat err_event。 - 将导出的信息与本文档附录中的Debugfs导出信息解析表进行对比,可以大致明确出现的问题。

9. 内核 错误注入测试支持

PCIe链路如果需要测试RC端funtion驱动、业务模型/EP端 firmware/双端硬件IP对错误的容错率,可以开启错误注入测试,模拟双方交互过程中可能出现的错误类型,评估双端软件、IP的稳定性。

使用方法

(1) 需要包含以下提交

commit fe835d5fd3329ba629f8c4290c818ef4b8f9895d

Author: Shawn Lin <shawn.lin@rock-chips.com>

Date: Wed Sep 4 17:04:37 2024 +0800

PCI: rockchip: dw: Add fault injection support

Change-Id: Ib214cc1be565bf16bafb6a847215572f35c43753

(2) 需要开启本文档中”内核 稳定性统计信息“章节所述功能�,并进入对应控制器的目录

(3) echo "einj_number enable_or_disable error_type error_number" >

fault_injection

|-------------------|--------------------------------------------------------

--|

| 数值 | 含义

|

|-------------------|--------------------------------------------------------

--|

|einj_number: |错误注入的组号,仅支持0到6,其他数值无效

|

|-------------------|--------------------------------------------------------

--|

|enable_or_disable: |开启错误注入还是关闭错误注入,0表示关闭,1表示开启,其他数值无效

|

|-------------------|--------------------------------------------------------

--|

|error_type: |错误注入类型选择,根据附录所述选择einj_number所示组号所对应的错误

类型|

|-------------------|--------------------------------------------------------

--|

|error_number: |错误注入数量,仅支持0到255,其他数值无效

|

|-------------------|--------------------------------------------------------

--|

例如echo "2 1 2 128" > fault_injection ,代表开启einj2,注入128个NAK DLLP包

(4) 启动PCIe链路传输,例如NVMe: dd if=/dev/nvme0n1 of=/dev/null bs=1M count=5000

(5) 查看错误是否发生:cat err_event

Rx Recovery Request: 0x1f

...

Tx Nak DLLP: 0x80

(6) 分析双端软硬件,查看是否发生预期外的软硬件异常

10. 内核 PMU perf支持

10.1 软件与配置

(1)需包含以下五个提交:

commit 0270f32f207f5682a729c17e977eb87bba83823e

Author: Shuai Xue <xueshuai@linux.alibaba.com>

Date: Fri Dec 8 10:56:50 2023 +0800

UPSTREAM: PCI: Move pci_clear_and_set_dword() helper to PCI header

Change-Id: I35125190a4dd8ba25e6ec14b4712750605c22285

commit 1b627c690ade9a72e3cd488e2e11edffb5d0e879

Author: Shuai Xue <xueshuai@linux.alibaba.com>

Date: Fri Dec 8 10:56:49 2023 +0800

UPSTREAM: PCI: Add Alibaba Vendor ID to linux/pci_ids.h

Change-Id: I86188f119a42548ab777df0449f7d0a933f34d12

commit dcfa6c8947baeac74ab44ea8f03d3831a062c14b

Author: Shuai Xue <xueshuai@linux.alibaba.com>

Date: Fri Dec 8 10:56:51 2023 +0800

BACKPORT: drivers/perf: add DesignWare PCIe PMU driver

Change-Id: I470f4dc2791168760517c77dd31a4dacd7dab591

commit 6cb6a00862fa29f815412634569e2015f86e397a

Author: Shawn Lin <shawn.lin@rock-chips.com>

Date: Tue Sep 3 16:24:36 2024 +0800

perf/dwc_pcie: Add support for Rockchip vendor devices

Change-Id: I6fde80440d2fa058b38a7d927eb846f477812b5f

commit 50cb3fcd18fb9defe23ba95eb3962a287e957166

Author: Shawn Lin <shawn.lin@rock-chips.com>

Date: Tue Sep 3 16:24:36 2024 +0800

PCI: rockchip: dw: Add dwc pmu support for rockchip

Change-Id: Ia27ee055aa3e63deeb7fd646411c3542b7019288

(2)内核需要开启CONFIG_PERF_EVENTS配置

(3)系统需要集成perf工具;若无,可以去本文档附录所述开发资源获取地址内下载

10.2 使用说明

(1) 列出所有DWC PCIe PMU支持的配置

root@rk3576-buildroot:/# /userdata/perf list | grep dwc_rootport

dwc_rootport_0/CFG_RCVRY/ [Kernel PMU event] #链路rcvry

时间占比

dwc_rootport_0/L0/ [Kernel PMU event] #链路处于L0

占比

dwc_rootport_0/L1/ [Kernel PMU event] #链路处于L1

占比

dwc_rootport_0/L1_1/ [Kernel PMU event] #链路处于

L1.1占比

dwc_rootport_0/L1_2/ [Kernel PMU event] #链路处于

L1.2占比

dwc_rootport_0/L1_AUX/ [Kernel PMU event] #RK不支持状

态

dwc_rootport_0/RX_L0S/ [Kernel PMU event] #RX处于L0s

占比

dwc_rootport_0/Rx_CCIX_TLP_Data_Payload/ [Kernel PMU event] #RK不支持

CCI数据统计

dwc_rootport_0/Rx_PCIe_TLP_Data_Payload/ [Kernel PMU event] #RX TLP数

据量

dwc_rootport_0/TX_L0S/ [Kernel PMU event] #TX处于L0s

占比

dwc_rootport_0/TX_RX_L0S/ [Kernel PMU event] #TX/RX都处

于L0s占比

dwc_rootport_0/Tx_CCIX_TLP_Data_Payload/ [Kernel PMU event] #RK不支持

CCI数据统计

dwc_rootport_0/Tx_PCIe_TLP_Data_Payload/ [Kernel PMU event] #TX TLP数

据量

dwc_rootport_0/one_cycle/ [Kernel PMU event] #RK不支持

dwc_rootport_0/rx_ack_dllp,lane=?/ [Kernel PMU event] #RX回复的

DLLP数

dwc_rootport_0/rx_atomic,lane=?/ [Kernel PMU event] #RK不支持

dwc_rootport_0/rx_ccix_tlp,lane=?/ [Kernel PMU event] #RK不支持

dwc_rootport_0/rx_completion_with_data,lane=?/ [Kernel PMU event] #RX cplt包

带数据

dwc_rootport_0/rx_completion_without_data,lane=?/ [Kernel PMU event] #RX cplt包

不带数据

dwc_rootport_0/rx_duplicate_tl,lane=?/ [Kernel PMU event] #RX/TL

dup错误数

dwc_rootport_0/rx_io_read,lane=?/ [Kernel PMU event] #RX上ior包

数

dwc_rootport_0/rx_io_write,lane=?/ [Kernel PMU event] #RX上iow包

数

dwc_rootport_0/rx_memory_read,lane=?/ [Kernel PMU event] #RX上memr

包数

dwc_rootport_0/rx_memory_write,lane=?/ [Kernel PMU event] #RX上memw

包数

dwc_rootport_0/rx_message_tlp,lane=?/ [Kernel PMU event] #RX上收到的

msg数

dwc_rootport_0/rx_nulified_tlp,lane=?/ [Kernel PMU event] #RX上因错丢

弃的TLP数

dwc_rootport_0/rx_tlp_with_prefix,lane=?/ [Kernel PMU event] #RX上带前缀

的TLP数

dwc_rootport_0/rx_update_fc_dllp,lane=?/ [Kernel PMU event] #RX上收到的

流控包数

dwc_rootport_0/tx_ack_dllp,lane=?/ [Kernel PMU event] #TX回复的

DLLP数

dwc_rootport_0/tx_atomic,lane=?/ [Kernel PMU event] #RK不支持

dwc_rootport_0/tx_ccix_tlp,lane=?/ [Kernel PMU event] #RK不支持

dwc_rootport_0/tx_completion_with_data,lane=?/ [Kernel PMU event] #TX cplt包

带数据

dwc_rootport_0/tx_completion_without_data,lane=?/ [Kernel PMU event] #TX cplt包

不带数据

dwc_rootport_0/tx_configuration_read,lane=?/ [Kernel PMU event] #TX cfg-r

包数

dwc_rootport_0/tx_configuration_write,lane=?/ [Kernel PMU event] #TX cfg-w

包数

dwc_rootport_0/tx_io_read,lane=?/ [Kernel PMU event] #TX上ior包

数

dwc_rootport_0/tx_io_write,lane=?/ [Kernel PMU event] #TX上iow包

数

dwc_rootport_0/tx_memory_read,lane=?/ [Kernel PMU event] #TX上memr

包数

dwc_rootport_0/tx_memory_write,lane=?/ [Kernel PMU event] #TX上memw

包数

dwc_rootport_0/tx_message_tlp,lane=?/ [Kernel PMU event] #TX上收到的

msg数

dwc_rootport_0/tx_nulified_tlp,lane=?/ [Kernel PMU event] #TX上因错丢

弃的TLP数

dwc_rootport_0/tx_tlp_with_prefix,lane=?/ [Kernel PMU event] #TX发出的带

前缀TLP数

dwc_rootport_0/tx_update_fc_dllp,lane=?/ [Kernel PMU event] #TX三发出的

流控包数

(2) 启动某项perf功能, 以基于时间的统计RX TLP为例

/userdata/perf stat -a -e dwc_rootport_0/Rx_PCIe_TLP_Data_Payload/

(3) 启动传输

root@rk3576-buildroot:/# dd if=/dev/nvme0n1 of=/dev/null bs=1M count=5000

dd if=/dev/nvme0n1 of=/dev/null bs=1M count=5000

5000+0 records in

5000+0 records out

5242880000 bytes (5.2 GB, 4.9 GiB) copied, 14.9016 s, 352 MB/s

(4) 查看统计

Performance counter stats for 'system wide':

5221423060 dwc_rootport_0/Rx_PCIe_TLP_Data_Payload/ (50.01%)

28.298528222 seconds time elapsed

(5) 同理可以测试TX TLP的数据量,则平均的RX/TX带宽计算

PCIe RX Bandwidth = Rx_PCIe_TLP_Data_Payload / 统计时长

PCIe TX Bandwidth = Tx_PCIe_TLP_Data_Payload / 统计时长

(6) Lane事件的统计

因为每个Lane都拥有相同的事件,为了避免产生大量冗余信息,建议指定Lane ID,例如:

/userdata/perf stat -a -e dwc_rootport_0/rx_memory_read,lane=1/

11. 常见应用问题

11.1 当走线位置不佳时�,不同lane之间能否交织?

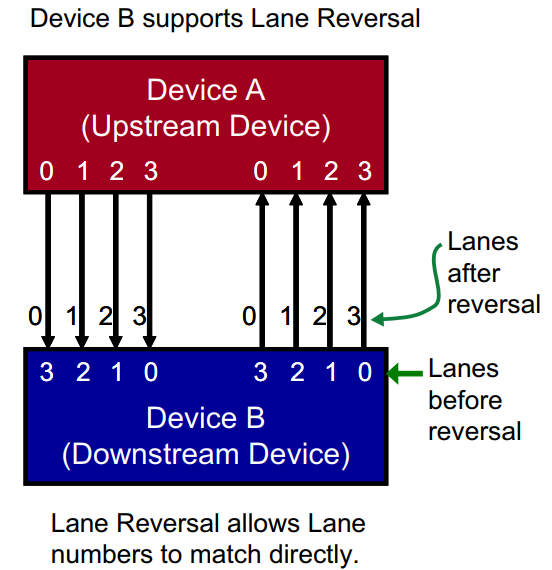

- 支持lane交织(Lane reversal),属于硬件协议行为,软件不需要改动。但是有如下限制:

- 4 Lane的情况下,目前RK平台仅支持全倒序交织,即RC的Lane[0.1.2.3] 分别对应 EP的 Lane[3.2.1.0],其余情况一概不支持。

- 2 Lane的情况下,同理支持RC的Lane[0.1]分别对应EP的Lane[1.0]。

不支持同一侧不同组lane之间的信号的组合使用,如RC lane0 TX与lane1 RX无法组合为一组lane来外接设备。

11.2 同一个lane的差分信号能否交织?

支持PN翻转(Lane polarity),通常RC TX+接入EP RX+、RC TX-接入EP RX-,支持RC TX+接入EP RX-等PN翻转布线,且软件不需要额外处理,由PCIe控制器自动探测。

不支持TX/RX交织,例如RC的lane1 TX无法与EP的lane1TX对接。

11.3 同一个PCIe接口是否支持拆分或者合并?

RK芯片的部分PCIe口可以支持拆分和合并功能,请参阅“芯片资源介绍”章节,具体方法参考示例和dts说明。

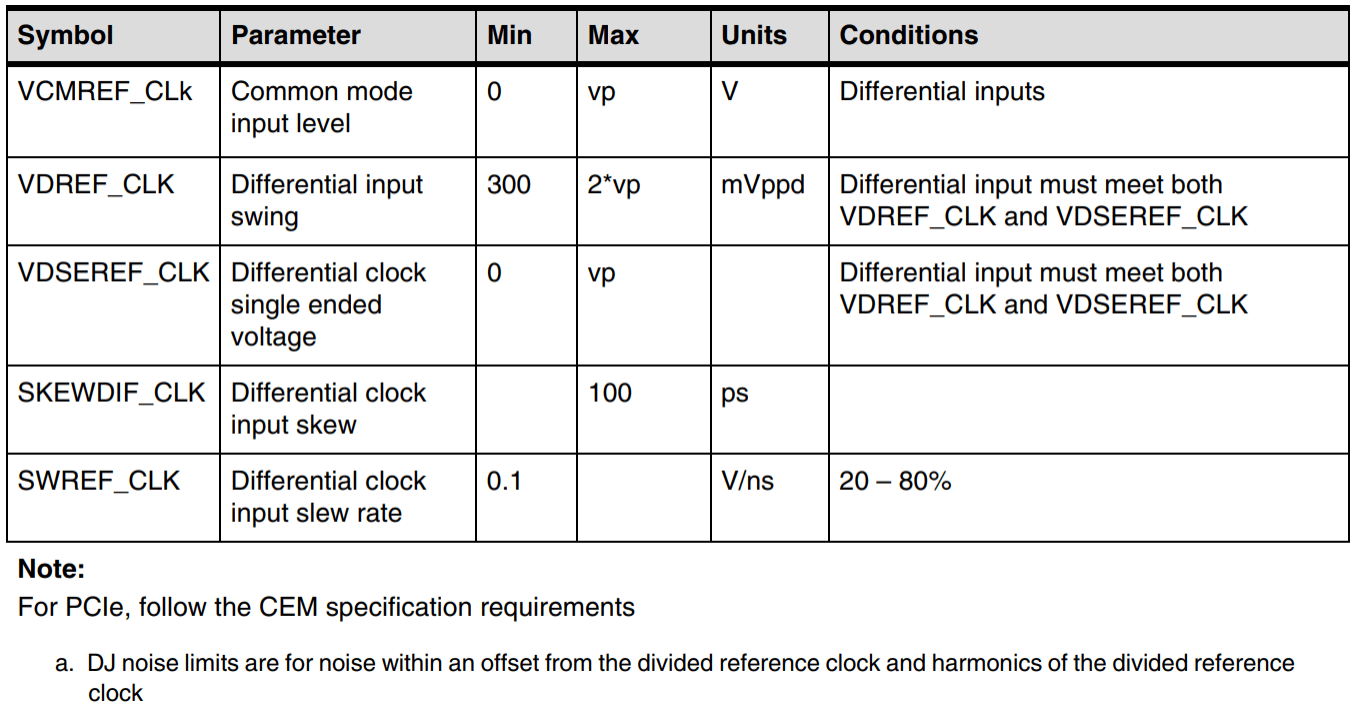

11.4 PCIe 3.0接口支持哪些时钟输入模式?

PCIe 3.0 的PHY的输入时钟模式可以是HCSL、LPHCSL或者其他差分信号,例如支持LVDS外加电平转换等电路实现的输入时钟方案,以上所有以满足PHY指标为准。

11.5 是否支持PCIe switch?贵司有没有推荐?

理论上支持,不需要任何补丁,且没有推荐列表。为了把控风险,请联系供应商借评估板,插在我司EVB上验证后再采购。

11.6 在系统中如�何确定控制器与设备的对应关系?

以RK3568芯片为例:

| 控制器 | Bus地址范围 |

|---|---|

| PCIe2x1控制器 | 0x00~0x0f |

| PCIe3x1控制器 | 0x10~0x1f |

| PCIe3x2控制器 | 0x20~0x2f |

从lspci输出的信息中可以看到各设备分配到的bus地址(高位),即可确定对应关系。第二列Class是设备类型,第三列VID:PID。

console:/ # lspci

21:00.0 Class 0108: 144d:a808

20:00.0 Class 0604: 1d87:3566

11:00.0 Class 0c03: 1912:0014

10:00.0 Class 0604: 1d87:3566

01:00.0 Class 0c03: 1912:0014

00:00.0 Class 0604: 1d87:3566

Class类型请参考https://pci-ids.ucw.cz/read/PD/,厂商VID和产品PID请参考http://pci-ids.ucw.cz/v2/pci.ids。

如果需要调整控制器的bus-range,请调整rk3568.dtsi中三个控制器的bus-range分配,且务必确保不要重叠。另外,调整bus-range将导致设备的MSI(-X) RID区间变化,请同步调整msi-map。

bus-range = <起始地址 结束地址>

msi-map = < bus-range中的起始地址 << 8

&its

bus-range中的起始地址 << 8

bus-range中分配的总线总数 << 8>

例如bus-range调整为0x30 ~ 0x60, 即该控制器下游设备分配的bus地址从0x30到0x60, 总线总数0x30个,则可配置msi-map如下:

msi-map = <0x3000 &its 0x3000 0x3000>;

依此类推,且一定要保证三个控制器的bus-range和msi-map互不重叠,且bus-range和msi-map相互适配。

11.7 如何确定PCIe设备的链路状态?

请使用服务器发布的lspci工具,执行lspci -vvv,找到对应设备的linkStat即可查看;其中Speed为速度,Width即为lane数。如需要解析其他信息,请查找搜索引擎,对照查看。

11.8 如何确定SoC针对PCIe设备可分配的MSI或者MSI-X数量?

SoC针对每个PCIe设备可分配的数量由中断控制器的资源决定。每个控制器的下游设备,RK1808/RK3566/RK3568/RK3588可分配的MSI或者MSI-X总数均是65535个,RK3528/RK3562/RK3576可分配的MSI或者MSI-X总数是8个。

11.9 是否支持Legacy INT方式?如何强制使用Legacy INTA ~ INTD的中断?

支持legacy INT方式。但Linux PCIe协议栈默认的优先级是MSI-X, MSI, Legacy INT,因此常规市售设备不会去申请Legacy INT。若调试测试需要,请参考内核中Documentation/admin-guide/kernel-parameters.txt文档,其中pci=option[,option...] [PCI] various PCI subsystem options.描述了可以在cmdline中关闭MSI,则系统默认会强制使用Legacy INT分配机制。以RK356X安卓平台为例,可在arch/arm64/boot/dts/rockchip/rk3568-android.dtsi的cmdline参数中额外添加一项pci=nomsi,注意前后项需空格隔开:

bootargs = "...... pci=nomsi ......";

如果添加成功,则lspci -vvv可以看到此设备的MSI和MSI-X都是处于关闭状态(Enable-),而分配了INT A中断,中断号是80。cat /proc/interrupts可查看到80中断的状态。

01:00.0 Class 0108: Device 14a4:22f1 (rev 01) (prog-if 02)

Subsystem: Device 1b4b:1093

...

Interrupt: pin A routed to IRQ 80

...

Capabilities: [50] MSI: Enable- Count=1/1 Maskable+ 64bit+

Address: 0000000000000000 Data: 0000

Masking: 00000000 Pending: 00000000

...

Capabilities: [b0] MSI-X: Enable- Count=19 Masked-

Vector table: BAR=0 offset=00002000

PBA: BAR=0 offset=00003000

11.10 芯片支持分配的BAR空间地址域有多大?

| 芯片型号 | 控制器 | 高端BAR起始地址 | 长度 | 低端BAR起始地址 | 长度 |

|---|---|---|---|---|---|

| RK1808 | PCIe2.0 | - | - | 0xF8000000 | 64MB |

| RK3528 | PCIe2.0 | 0x100000000 | 1GB | 0xFC000000 | 32MB |

| RK3562 | PCIe2.0 | 0x300000000 | 1GB | 0xFC000000 | 32MB |

| RK3566/RK3568 | PCIe2.0 | 0x300000000 | 1GB | 0xF4000000 | 32MB |

| RK3566/RK3568 | PCIe3x1 | 0x340000000 | 1GB | 0xF2000000 | 32MB |

| RK3566/RK3568 | PCIe3x2 | 0x380000000 | 1GB | 0xF0000000 | 32MB |

| RK3576 | PCIe0 | 0x900000000 | 2GB | 0x20000000 | 16MB |

| RK3576 | PCIe1 | 0x980000000 | 2GB | 0x21000000 | 16MB |

| RK3588(s) | pcie3x4 | 0x900000000 | 1GB | 0xf0000000 | 16MB |

| RK3588(s) | pcie3x2 | 0x940000000 | 1GB | 0xf1000000 | 16MB |

| RK3588(s) | pcie2x1l0 | 0x980000000 | 1GB | 0xf2000000 | 16MB |

| RK3588(s) | pcie2x1l1 | 0x9c0000000 | 1GB | 0xf3000000 | 16MB |

| RK3588(s) | pcie2x1l2 | 0xa00000000 | 1GB | 0xf4000000 | 16MB |

PCIe控制器支持最大的64-bit的BAR空间见上图,其中外设配置空间、IO空间和MEM空间共享这地址段,且MEM空间不支持预取功能。

11.11 如果CPU运行在32位地址模式下,如何实现BAR空间的访问?

默认状态下,芯片给PCIe控制器分配的BAR空间均位于超出32位寻址的地址段。但是我们芯片有预留32位以下的一个BAR地址,对每个控制器有不同的限制。例如,RK3568芯片每个控制器的低位BAR地址仅有32MB,当RK3568的CPU运行在32位地址模式下,此时我们应该启用低位地址空间对每个PCIe节点的ranges进行重新分配。以下例子已经修改为配置空间1MB,IO空间1MB和32-bit MEM空间30MB:

<0x00000800 0x0 0xF4000000 0x0 0xF4000000 0x0 0x100000>

<0x81000000 0x0 0xF4100000 0x0 0xF4100000 0x0 0x100000>

<0x82000000 0x0 0xF4200000 0x0 0xF4200000 0x0 0x1e00000>;

&pcie3x1 {

ranges = <0x00000800 0x0 0xF2000000 0x0 0xF2000000 0x0 0x100000

0x81000000 0x0 0xF2100000 0x0 0xF2100000 0x0 0x100000

0x82000000 0x0 0xF2200000 0x0 0xF2200000 0x0 0x1e00000>;

}

&pcie3x2 {

ranges = <0x00000800 0x0 0xF0000000 0x0 0xF0000000 0x0 0x100000

0x81000000 0x0 0xF0100000 0x0 0xF0100000 0x0 0x100000

0x82000000 0x0 0xF0200000 0x0 0xF0200000 0x0 0x1e00000>;

}

如需调整各个空间的大小,可参考附录中“关于PCIe地址空间配置详述”的部分。

11.12 如何查看芯片分配给外设的CPU域地址以及PCIe bus域地址,两者如何对应?

使用lspci命令可以看到各设备CPU域地址以及PCIe bus域地址:

root@linaro-alip: /home/linaro# lspci -Vs 0002:21:00.0 -X

0002:21:00.0 Non-Volatile memory controller: Intel Corporation SSD Pro 7600p/760p/E 6100p Series (rev 03) (prog-if 02 [NVM Express])

Subsystem: Intel Corporation SSD Pro 7600p/760p/E 6100p Series

Flags: bus master, fast devsel, latency 0,IRQ 114

Memory at 380900000 (64-bit, non-prefetchable) [size=16K]

Capabilities: [40] Power Management version 3

...

00: 86 80 a6 f1 06 04 10 00 03 02 08 01 00 00 00 00

10: 04 00 90 80 00 00 00 00 00 00 00 00 00 00 00 00

20: 00 00 00 00 00 00 00 00 00 00 00 00 86 80 0b 39

30: 00 00 00 00 40 00 00 00 00 00 00 00 72 01 00 00

我们可以看出,芯片给外设分配的CPU域地址是0x380900000;CPU若需要访问外设,可以直接用IO命令或者devmem命令读取0x380900000。而0x380900000这个CPU域地址对应的PCIe bus域地址,可以从PCIe外设的BAR0地址(偏移0x10开始到0x14为止)读出“04 00 90 80”,即为0x80900000(最低位04是表明此BAR的类型为64bit MEM)。因此当CPU发出访问0x380900000这个CPU域地址时,PCIe的地址转换服务(ATU),通过所配置的outbound关系,可以发出0x80900000这个PCIe bus域地址,从而实现CPU访问到PCIe外设的内部信息。

而两者的对应关系在rk3568.dtsi中有定义,我们以pcie3x2为例:

ranges = <0x00000800 0x0 0x80000000 0x3 0x80000000 0x0 0x800000

0x81000000 0x0 0x80800000 0x3 0x80800000 0x0 0x100000 IO空间

0x83000000 0x0 0x80900000 0x3 0x80900000 0x0 0x3f700000>; Memory空间

例如我们可查看到Memory段的详细分配情况。首段0x83000000表明此memory段为64-bit non-prefetch空间。

0x3 0x80900000为芯片分配的CPU域地址,即0x0000000380900000;0x0 0x80900000为分配的CPU域地址所对应的PCIe bus域地址,即0x0000000080900000;0x3f700000为此memory段的总大小。因此CPU发出的CPU域访问地址与转换后的PCIe bus域地址存在0x300000000的偏移关系,这部分偏移关系在硬件上由ATU自动转化。

关于地址空间的配置详情,可参考附录中“关于PCIe地址空间配置详述”的部分。

11.13 如何对下游单个设备进行重扫描或者在线更换设备?

若有如下两点需求则需对下游设备��进行重枚举:

- 下游设备可能在不同阶段出现bar空间变化;

- 下游设备损坏后进行在线更换;

(1) 找出下游所需更换或者重扫描设备,目前我们以BDF为01:00.0的这个设备为例

console:/ # /data/lspci -k

00:00.0 Class 0604: Device 1d87:3566 (rev 01)

Kernel driver in use: pcieport

01:00.0 Class 0c03: Device 1912:0014 (rev 03)

(2) 对设备进行remove操作,可看到对应设备节点以及它所运行的pcie driver被反初始化

console:/ # echo 1 > /sys/bus/pci/devices/0000\:01\:00.0/remove

[ 30.624938] xhci_hcd 0000:01:00.0: remove, state 4

[ 30.624985] usb usb8: USB disconnect, device number 1

[ 30.625741] xhci_hcd 0000:01:00.0: USB bus 8 deregistered

[ 30.626115] xhci_hcd 0000:01:00.0: remove, state 4

[ 30.626142] usb usb7: USB disconnect, device number 1

[ 30.640977] xhci_hcd 0000:01:00.0: USB bus 7 deregistered

[ 32.055886] vcc5v0_otg: disabling

[ 32.055920] vcc3v3_lcd1_n: disabling

(3) 可再次查看,确定设备已经无法扫描到了

console:/ # /data/lspci -k

00:00.0 Class 0604: Device 1d87:3566 (rev 01)

Kernel driver in use: pcieport

(4) 发起总线重扫描,可任选如下两条指令之一,执行后新设备恢复识别

console:/ # echo 1 > /sys/bus/pci/devices/0000\:00\:00.0/rescan

console:/ # echo 1 > /sys/bus/pci/rescan

[ 33.222240] pci 0000:01:00.0: BAR 0: assigned [mem 0x300900000-0x300900fff

64bit]

[ 33.222606] xhci_hcd 0000:01:00.0: xHCI Host Controller

[ 33.224875] xhci_hcd 0000:01:00.0: new USB bus registered, assigned bus number

7

[ 33.225468] xhci_hcd 0000:01:00.0: hcc params 0x002841eb hci version 0x100

quirks 0x0000000000000090

[ 33.226318] usb usb7: New USB device found, idVendor=1d6b, idProduct=0002,

bcdDevice= 4.19

[ 33.226329] usb usb7: New USB device strings: Mfr=3, Product=2, SerialNumber=1

[ 33.226345] usb usb7: Product: xHCI Host Controller

[ 33.226355] usb usb7: Manufacturer: Linux 4.19.172 xhci-hcd

[ 33.226364] usb usb7: SerialNumber: 0000:01:00.0

[ 33.227661] hub 7-0:1.0: USB hub found

[ 33.227716] hub 7-0:1.0: 1 port detected

[ 33.228252] xhci_hcd 0000:01:00.0: xHCI Host Controller

[ 33.228581] xhci_hcd 0000:01:00.0: new USB bus registered, assigned bus number

8

[ 33.226816] xhci_hcd 0000:01:00.0: Host supports USB 3.0 SuperSpeed

[ 33.228678] usb usb8: We don't know the algorithms for LPM for this host,

disabling LPM.

[ 33.228783] usb usb8: New USB device found, idVendor=1d6b, idProduct=0003,

bcdDevice= 4.19

[ 33.228796] usb usb8: New USB device strings: Mfr=3, Product=2, SerialNumber=1

[ 33.228803] usb usb8: Product: xHCI Host Controller

[ 33.228809] usb usb8: Manufacturer: Linux 4.19.172 xhci-hcd

[ 33.228814] usb usb8: SerialNumber: 0000:01:00.0

[ 33.229360] hub 8-0:1.0: USB hub found

[ 33.229406] hub 8-0:1.0: 4 ports detected

[ 33.556216] usb 7-1: new high-speed USB device number 2 using xhci_hcd

[ 33.700886] usb 7-1: New USB device found, idVendor=2109, idProduct=3431,

bcdDevice= 4.20

[ 33.700913] usb 7-1: New USB device strings: Mfr=0, Product=1, SerialNumber=0

[ 33.700920] usb 7-1: Product: USB2.0 Hub

[ 33.702398] hub 7-1:1.0: USB hub found

[ 33.702642] hub 7-1:1.0: 4 ports detected

11.14 PCIe外设及其function驱动如何处理cache一致性?

根据PCIe协议Snoop和No Snoop的定义,外设向主机系统进行访问请求,其TLP包需要设置No Snoop属性位,来表征是否需要主机系统的硬件协助其完成cache一致性的维护。

| No | Cache Coherency | Col3 | Col4 |

|---|---|---|---|

| 管理模型 | 备注 | ||

| Snoop位 | 类型 | ||

| 0 | Snoop | 硬件保证cache一致性 | Cfg包,I/O包,Message包,MSI(-)包必须设置为0 |

| 1 | No Snoop | 外设驱动维护cache一致性 | - |

当外设发出写入主机内存的TLP包,若其No Snoop位为0,进入主机系统后,RC将检查所写入的地址是否落入其他CPU的cache内。若是,则需要在数据写入物理内存后,对所有含有此地址缓存的CPU执行invalidate操作。

当外设发来从主机内存取数据并送往外设的TLP包,若其No Snoop位为0,则RC将检查所有CPU的cache,确定该TLP包内数据所在的地址是否有被其他CPU缓存。若是,则在取数据之前进行flush操作。

RK平台的部分芯片体系并不支持Snoop类型,统一按照No Snoop为1处理。因此运行的function驱动需要自行维护cache一致性。支持Snoop类型的,芯片可以保证cache一致性。

| 不支持PCIe cache一致性的平台 | 支持PCIe cache一致性的平台 |

|---|---|

| RK1808、RK3528、RK3562、RK3566、RK3568、RK3588(s) | RK3576 |

11.15 是否支持PCIe设备使用beacon方式唤醒主控?

RK平台不支持在L2的状态下,由PCIe设备发送beacon唤醒主控。如果有唤醒需求,请使用#WAKE信号当作GPIO唤醒源方式实现。

11.16 如何通过命令从RK PCIe EP发起MSI中断?

测试前确认:

- RC和EP都支持并使能MSI cap,RK RC和RK EP默认已使能MSI cap

- RC 上运行EP的function驱动,并已申请msi中断

RK PCIe EP client寄存器PCIE_CLIENT_MSI_GEN_CON支持触发MSI中断,32bits寄存器分别对应32个msi中断,以RK3588为例:

io -4 0xFE150038 1

除此之外,还可通过:

- 设置outbound atu,CPU写发起memory write

- 或通过DMA传输发起memory write

部分PC只能申请一个MSI中断,例如包括Linux系统和Windows系统,主要受PC BIOS配置限制,例如:

- Intel BIOS虚拟化及VT-d配置

- Interrupt remapper support

RK3588 RC上能申请32个MSI中断。

11.17 如何通过命令从RK PCIe EP发起MSI-X中断?

原理

PC通过标准的MSI-X cap映射BAR4配置MSI table

RK3568实例:

# 加载驱动后msix配置后状态,从设备端执行以下两条命令可以看到MSI-Xtable

io -4 0xfe280270 0x10001 # 测试时开启 Dbi writeable

io -4 -l 0x100 0xf6300000

io -4 0xfe280270 0x10000

f6300000: fee02004 00000000 00000024 00000000

f6300010: fee08004 00000000 00000024 00000000

f6300020: fee01004 00000000 00000024 00000000

f6300030: fee02004 00000000 00000025 00000000

f6300040: fee08004 00000000 00000025 00000000

f6300050: fee01004 00000000 00000025 00000000

f6300060: fee02004 00000000 00000026 00000000

f6300070: fee04004 00000000 00000026 00000000

f6300080: 00000000 00000000 00000000 00000001

f6300090: 00000000 00000000 00000000 00000001

f63000a0: 00000000 00000000 00000000 00000001

f63000b0: 00000000 00000000 00000000 00000001

f63000c0: 00000000 00000000 00000000 00000001

f63000d0: 00000000 00000000 00000000 00000001

f63000e0: 00000000 00000000 00000000 00000001

f63000f0: 00000000 00000000 00000000 00000001

# 由于当前业务没有提供 MSI-X 接口示例,可通过以下方式触发 MSI-X

# 设置设备 outbound,默认RK EP outbound 配置 CPU addr 为 0xf0000000,测试时未改动,或者

通过内核接口完成 Bar outbound 配置

io -4 0xf6300014 0xfee00000 # 指向前面的 io -4 -l 0x100 0xf5300000 输出地址

io -4 0xf6300018 0x0

# 触发 MSI-X

io -4 0xf0002004 0x24

io -4 0xf0008004 0x24

io -4 0xf0001004 0x24

io -4 0xf0002004 0x25

io -4 0xf0008004 0x25

io -4 0xf0001004 0x25

io -4 0xf0002004 0x26

io -4 0xf0004004 0x26

RK3588实例:

# 加载驱动后 msix 配置后状态,从设备端执行以下两条命令可以看到 MSI-X table

io -4 0xfe150270 0x10001 # 测试时开启 Dbi writeable

io -4 -l 0x100 0xf5300000

io -4 0xfe150270 0x10000

f5300000: fee02004 00000000 00000024 00000000

f5300010: fee08004 00000000 00000024 00000000

f5300020: fee01004 00000000 00000024 00000000

f5300030: fee02004 00000000 00000025 00000000

f5300040: fee08004 00000000 00000025 00000000

f5300050: fee01004 00000000 00000025 00000000

f5300060: fee02004 00000000 00000026 00000000

f5300070: fee04004 00000000 00000026 00000000

f5300080: 00000000 00000000 00000000 00000001

f5300090: 00000000 00000000 00000000 00000001

f53000a0: 00000000 00000000 00000000 00000001

f53000b0: 00000000 00000000 00000000 00000001

f53000c0: 00000000 00000000 00000000 00000001

f53000d0: 00000000 00000000 00000000 00000001

f53000e0: 00000000 00000000 00000000 00000001

f53000f0: 00000000 00000000 00000000 00000001

# 由于当前业务没有提供 MSI-X 接口示例,可通过以下方式触发 MSI-X

# 设置设备 outbound,默认RK EP outbound 配置 CPU addr 为 0xf0000000,测试时未改动,或者

通过内核接口完成 Bar outbound 配置

io -4 0xf5300014 0xfee00000 # 指向前面的 io -4 -l 0x100 0xf5300000 输出地址

io -4 0xf5300018 0x0

# 触发 MSI-X

io -4 0xf0002004 0x24

io -4 0xf0008004 0x24

io -4 0xf0001004 0x24

io -4 0xf0002004 0x25

io -4 0xf0008004 0x25

io -4 0xf0001004 0x25

io -4 0xf0002004 0x26

io -4 0xf0004004 0x26

11.18 如何修改增加32bits-np映射地址空间?

背景

PCIe mmio空间为CPU发起PCIe传输的映射地址空间,物理地址专用,Dram不包括此段空间,每个PCIe控制器有专用的mmio空间,通常为32MB 32bits地址空间和1GB 64bits地址空间。

PCIe range为CPU访问地址和PCI域虚拟地址之间的映射,PCIe range分配的原则:

- 域地址与Dram物理地址不能重叠,避免EP端DMA地址混乱导致访问错误,所以

- 默认域地址分配在对应PCIe控制器mmio物理地址,与PCIe mmio空间一一对应

- 扩展少量32bits-np域地址空间,建议跨用其他PCIe控制器mmio物理地址

- 继续扩充更多32bits-np域地址空间,建议reserved 4GB内memory空间做进一步分配

默认配置提供确认,以RK3588为例:

[ 5.325570] pci_bus 0000:00: root bus resource [mem 0xf0200000-0xf0ffffff] # RC 14MB 32bits-np mem

[ 5.325577] pci_bus 0000:00: root bus resource [mem 0x900000000-0x93fffffff pref] # RC 1GB 64bits-pref mem

问题:默认分配32bits-np空间不足

log:

[ 11.646077] pci 0000:01:00.0: reg 0x10: [mem 0x00000000-0x00ffffff 64bit] # Dev总共需求26MB 32bits-np,最终会对齐需求32MB空间

[ 11.646113] pci 0000:01:00.0: reg 0x18: [mem 0x00000000-0x007fffff 64bit]

[ 11.646150] pci 0000:01:00.0: reg 0x20: [mem 0x00000000-0x001fffff 64bit]

...

[ 11.971710] pci 0000:01:00.0: BAR 0: no space for [mem size 0x01000000 64bit]

[ 11.971713] pci 0000:01:00.0: BAR 0: failed to assign [mem size 0x01000000 64bit]

[ 11.971717] pci 0000:01:00.0: BAR 2: no space for [mem size 0x00800000 64bit]

[ 11.971720] pci 0000:01:00.0: BAR 2: failed to assign [mem size 0x00800000 64bit]

[ 11.971723] pci 0000:01:00.0: BAR 4: no space for [mem size 0x00200000 64bit]

[ 11.971726] pci 0000:01:00.0: BAR 4: failed to assign [mem size 0x00200000 64bit]

解决补丁参考

参考 TRM 确认 PCIe 专用的内存空间,然后新增所缺mem range资源。

实例1:RK3588 pcie3x4修改240MB 32bits-np映射空间配置,修改内核rk3588.dtsi对应节点range属性为:

ranges = <0x00000800 0x0 0xff000000 0x0 0xf0000000 0x0 0x100000

0x81000000 0x0 0xff100000 0x0 0xf0100000 0x0 0x100000

0x82000000 0x0 0xf0000000 0x9 0x00000000 0x0 0x0f000000

0xc3000000 0x9 0x10000000 0x9 0x10000000 0x0

0x30000000>;

实例2:RK3588s pcie2x1l2修改240MB 32bits-np映射空间配置,修改内核rk3588s.dtsi对应节点range属性为:

ranges = <0x00000800 0x0 0xff000000 0x0 0xf4000000 0x0 0x100000

0x81000000 0x0 0xff100000 0x0 0xf4100000 0x0 0x100000

0x82000000 0x0 0xf0000000 0xa 0x00000000 0x0 0x0f000000

0xc3000000 0xa 0x10000000 0xa 0x10000000 0x0

0x30000000>;

实例3:RK3588 pcie2x1l0修改240MB 32bits-np映射空间配置,修改内核rk3588.dtsi对应节点range属性为:

ranges = <0x00000800 0x0 0xff000000 0x0 0xff000000 0x0 0x100000

0x81000000 0x0 0xff100000 0x0 0xff100000 0x0 0x100000

0x82000000 0x0 0xf0000000 0x9 0x80000000 0x0 0x0f000000

0xc3000000 0x9 0x90000000 0x9 0x90000000 0x0

0x30000000>;

实例3:RK3568 pcie3x2修改240MB 32bits-np映射空间配置,修改内核rk356x.dtsi对应节点range属性 为:

ranges = <0x00000800 0x0 0xff000000 0x0 0xf0000000 0x0 0x100000

0x81000000 0x0 0xff100000 0x0 0xf0100000 0x0 0x100000

0x82000000 0x0 0xf0000000 0x3 0x80000000 0x0 0x0f000000

0xc3000000 0x3 0x90000000 0x3 0x90000000 0x0

0x30000000>;

实例4:基于实例1新增0x30000000处的256M映射内存,并做按照要求做内存预留:

diff --git a/arch/arm64/boot/dts/rockchip/rk3588-evb1-lp4.dtsi

b/arch/arm64/boot/dts/rockchip/rk3588-evb1-lp4.dtsi

index a10dad37f9cf..d1b16e13c459 100644

--- a/arch/arm64/boot/dts/rockchip/rk3588-evb1-lp4.dtsi

+++ b/arch/arm64/boot/dts/rockchip/rk3588-evb1-lp4.dtsi

@@ -233,6 +233,15 @@ wireless_wlan: wireless-wlan {

WIFI,poweren_gpio = <&gpio3 RK_PB1 GPIO_ACTIVE_HIGH>;

status = "okay";

};

+

+ reserved-memory {

+ #address-cells = <2>;

+ #size-cells = <2>;

+ ranges;

+ pcie3x4_range: pcie3x4-range@30000000 {

+ reg = <0x0 0xdfe00000 0x0 0x10200000>;

+ };

+ };

};

&backlight {

diff --git a/arch/arm64/boot/dts/rockchip/rk3588.dtsi

b/arch/arm64/boot/dts/rockchip/rk3588.dtsi

index ad414c61fd38..096f16740e11 100644

--- a/arch/arm64/boot/dts/rockchip/rk3588.dtsi

+++ b/arch/arm64/boot/dts/rockchip/rk3588.dtsi

@@ -601,10 +601,11 @@ pcie3x4: pcie@fe150000 {

phys = <&pcie30phy>;

phy-names = "pcie-phy";

power-domains = <&power RK3588_PD_PCIE>;

- ranges = <0x00000800 0x0 0xf0000000 0x0 0xf0000000 0x0 0x100000

- 0x81000000 0x0 0xf0100000 0x0 0xf0100000 0x0 0x100000

- 0x82000000 0x0 0xf0200000 0x0 0xf0200000 0x0 0xe00000

- 0xc3000000 0x9 0x00000000 0x9 0x00000000 0x0

0x40000000>;

+ ranges = <0x00000800 0x0 0xdfe00000 0x0 0xf0000000 0x0 0x100000

+ 0x81000000 0x0 0xdff00000 0x0 0xf0100000 0x0 0x100000

+ 0x82000000 0x0 0xe0000000 0x9 0x00000000 0x0

0x20000000 // 扩展至512MB

+ 0xc3000000 0x9 0x20000000 0x9 0x20000000 0x0

0x20000000>;

reg = <0x0 0xfe150000 0x0 0x10000>,

<0xa 0x40000000 0x0 0x400000>;

reg-names = "pcie-apb", "pcie-dbi";

11.19 如何配置max payload size?

PCIe以TLP的形式发送数据,而max payload size(简称mps)决定了pcie设备的tlp能够传输的最大字节数。mps的大小是由PCIe链路两端的设备协商决定的,PCIe设备发送TLP时,其最大payload不能超过mps的值。

内核提供基于dts的"[PCI] various PCI subsystem options."配置,详细参考“Documentation/admin-guide/kernel-parameters.txt”文档,相关配置如下:

pcie_bus_tune_off#关闭mps调整,使用设备自身默认值pcie_bus_safe#开启mps调整,设置所有设备都支持的最大mps值pcie_bus_perf#开启mps调整,根据parent bus及自身capability设置为最大mpspcie_bus_peer2peer#开启mps调整,设置所有设备为mps为128B

说明:

- 内核默认max payload size配置机制为

pcie_bus_tune_off - 通常可以考虑直接在dts bootargs添加

pci=pcie_bus_safe属性

11.20 如何固定被枚举设备的ID号?

当系统中出现多路同类型的PCIe设备,如多个网卡,由于初始化顺序不固定的情况,所以eth0代表哪一路设备实际并不固定。同样的情况也适用于NVMe等。用户如果希望将被枚举设备的ID进行固定,需要修改对应的function驱动,修改的理论基础是设备的bus number是DTS固定分配的。以下两个例子可供参考:

如果RK3588接了三个网卡,想按下面顺序固定:

pcie2x1l0: pcie@fe170000 => eth1

pcie2x1l2: pcie@fe190000 => eth2

pcie2x1l1: pcie@fe180000 => eth3

查询dtsi可知:

pcie2x1l0节点:bus-range = <0x20 0x2f> -> 网卡分配的bus number为0x21 -> eth1

pcie2x1l2节点:bus-range = <0x40 0x4f> -> 网卡分配的bus number为0x41 -> eth2

pcie2x1l1节点:bus-range = <0x30 0x3f> -> 网卡分配的bus number为0x31 -> eth3

修改对应的function驱动,在register_netdev函数被调用前修改注册到网络子系统的名字。

--- a/drivers/net/ethernet/realtek/r8168/r8168_n.c

+++ b/drivers/net/ethernet/realtek/r8168/r8168_n.c

@@ -25481,6 +25481,18 @@ static const struct net_device_ops rtl8168_netdev_ops =

{

};

#endif

+static void pci_bus_nr_2_id(struct pci_dev *pdev, struct net_device *ndev )

+{

+

+ dev_info(&pdev->dev, "%s pdev->bus->number = 0x%x\n",

+ __func__, pdev->bus->number);

+

+ if(pdev->bus->number == 0x21)

+ strcpy(ndev->name, "eth1");

+ if(pdev->bus->number == 0x41)

+ strcpy(ndev->name, "eth2");

+ if(pdev->bus->number == 0x31)

+ strcpy(ndev->name, "eth3");

+}

+

static int __devinit

rtl8168_init_one(struct pci_dev *pdev,

const struct pci_device_id *ent)

@@ -25624,7 +25636,7 @@ rtl8168_init_one(struct pci_dev *pdev,

rtl8168_set_eeprom_sel_low(tp);

rtl8168_get_mac_address(dev);

-

+ pci_bus_nr_2_id(pdev, dev); // 修改位置一定要在register_netdev()之前

tp->fw_name = rtl_chip_fw_infos[tp->mcfg].fw_name;

同理NVMe存储器可参考类似修改

--- a/drivers/nvme/host/core.c

+++ b/drivers/nvme/host/core.c

@@ -5169,6 +5169,19 @@ static void nvme_free_ctrl(struct device *dev)

nvme_put_subsystem(subsys);

}

+static void pci_bus_nr_2_id(struct pci_dev *pdev, struct nvme_ctrl *ctrl)

+{

+ dev_info(&pdev->dev, "%s pdev->bus->number = 0x%x\n",

+ __func__, pdev->bus->number);

+

+ if(pdev->bus->number == 0x21)

+ ctrl->instance = 1; //pcie2x1l0 -> nvme1

+ if(pdev->bus->number == 0x41)

+ ctrl->instance = 2; //pcie2x1l2 -> nvme2

+ if(pdev->bus->number == 0x31)

+ ctrl->instance = 3; //pcie2x1l1 -> nvme3

+}

+

/*

* Initialize a NVMe controller structures. This needs to be called during

* earliest initialization so that we have the initialized structured around

@@ -5178,6 +5191,7 @@ int nvme_init_ctrl(struct nvme_ctrl *ctrl, struct device

*dev,

const struct nvme_ctrl_ops *ops, unsigned long quirks)

{

int ret;

+ struct pci_dev *pdev = container_of(dev, struct pci_dev, dev);

ctrl->state = NVME_CTRL_NEW;

clear_bit(NVME_CTRL_FAILFAST_EXPIRED, &ctrl->flags);

@@ -5214,6 +5228,8 @@ int nvme_init_ctrl(struct nvme_ctrl *ctrl, struct device

*dev,

goto out;

ctrl->instance = ret;

+ pci_bus_nr_2_id(pdev, ctrl);

device_initialize(&ctrl->ctrl_device);

ctrl->device = &ctrl->ctrl_device;

ctrl->device->devt = MKDEV(MAJOR(nvme_ctrl_base_chr_devt),

12. 异常排查

12.1 驱动加载失败

[ 0.417008] rk-pcie 3c0000000.pcie: Linked as a consumer to regulator.14

[ 0.417477] rk-pcie 3c0800000.pcie: Linked as a consumer to regulator.14

[ 0.417648] rk-pcie 3c0800000.pcie: phy init failed

异常原因:dts中未正确开启此控制器所对应的phy节点。

[ 0.195567] rochchip_p3phy_init: lock failed 0x6890000, check input refclk and power supply

[ 0.195585] phy phy-fe8c0000.phy.8: phy init failed --> -110

[ 0.195599] rk-pcie 3c0800000.pcie: fail to init phy, err -110

[ 0.195611] rk-pcie 3c0800000.pcie: phy init failed

异常原因:PCIe 3.0 PHY工作电源或者输入时钟异常,导致phy没有正常工作。

12.2 trainning 失败

PCIe Link Fail的log如下一直重复”PCIe Linking...“,LTSSM状态机可能不同

rk-pcie 3c0000000.pcie: PCIe Linking... LTSSM is 0x0

rk-pcie 3c0000000.pcie: PCIe Linking... LTSSM is 0x0

rk-pcie 3c0000000.pcie: PCIe Linking... LTSSM is 0x0

或者出现"PCIe Link up"的打印, 但LTSSM状态机的bit16与bit17不等于0x3, bit0到bit8数值不大于

0x11

[ 3.108325] rk-pcie fe150000.pcie: Looking up vpcie3v3-supply from device tree

[ 3.126926] rk-pcie fe150000.pcie: missing legacy IRQ resource

[ 3.126940] rk-pcie fe150000.pcie: IRQ msi not found

[ 3.126944] rk-pcie fe150000.pcie: use outband MSI support

[ 3.126947] rk-pcie fe150000.pcie: Missing *config* reg space

[ 3.126954] rk-pcie fe150000.pcie: host bridge /pcie@fe150000 ranges:

[ 3.126965] rk-pcie fe150000.pcie: err 0x00f0000000..0x00f00fffff ->

0x00f0000000

[ 3.126972] rk-pcie fe150000.pcie: IO 0x00f0100000..0x00f01fffff ->

0x00f0100000

[ 3.126979] rk-pcie fe150000.pcie: MEM 0x00f0200000..0x00f0ffffff ->

0x00f0200000

[ 3.126984] rk-pcie fe150000.pcie: MEM 0x0900000000..0x090fffffff ->

0x0900000000

[ 3.127007] rk-pcie fe150000.pcie: Missing *config* reg space

[ 3.127028] rk-pcie fe150000.pcie: invalid resource

[ 3.387304] rk-pcie fe150000.pcie: PCIe Link up, LTSSM is 0x0

真正如果link成功,应该可以看到类似log, 出现"PCIe Link up"的打印,且LTSSM状态机的bit16与

bit17等于0x3, bit0到bit8数值大等于0x11

[ 2.410536] rk-pcie 3c0000000.pcie: PCIe Link up, LTSSM is 0x130011

异常原因:trainning 失败,外设没有处于工作状态或者信号异常。首先检测下 reset-gpios 这个是否配置对了。其次,检测下外设的3V3供电是否有,是否足够,部分外设需要12V电源。最后测试复位信号与电源的时序是否与此设备的spec冲突。如果都无法解决,大概率需要定位信号完整性,需要拿出测试眼图和PCB给到我司硬件,并且最好我们建议贵司找实验室提供一份测试TX兼容性信号测试报告。

另外还建议客户打开pcie-dw-rockchip.c中的RK_PCIE_DBG,抓一份log以便分析。请阅读者注意,如果有多个控制器同时使用,抓log前请先把不使用或者没问题的设备对应的控制器disable掉,这样log会好分析一点。所抓取的log中,将会出现类似“rk-pcie 3c0000000.pcie: fifo_status = 0x144001”等信息。fifo_status的末尾两位是PCIe链路的ltssm状态机,可以根据状态机信息判断异常发生的大致情况。芯片的PCIe ltssm状态机信息可参照文末附录部分。

12.3 PCIe3.0控制器初始化设备系统异常

[ 21.523506] rcu: INFO: rcu_preempt detected stalls on CPUs/tasks:

[ 21.523557] rcu: 1-...0: (0 ticks this GP) idle=652/1/0x4000000000000000 softirq=30/30 fqs=2097

[ 21.523579] rcu: 3-...0: (5 ticks this GP) idle=4fa/1/0x4000000000000000 softirq=35/36 fqs=2097

[ 21.523590] rcu: (detected by 2, t=6302 jiffies, g=-1151, q=98)

[ 21.523610] Task dump for CPU 1:

[ 21.523622] rk-pcie R running task 0 55 2 0x0000002a

[ 21.523640] Call trace:

[ 21.523666] __switch_to+0xe0/0x128

[ 21.523682] 0x43752cfcfe820900

[ 21.523694] Task dump for CPU 3:

[ 21.523704] kworker/u8:0 R running task 0 7 2 0x0000002a

[ 21.523737] Workqueue: events_unbound enable_ptr_key_workfn

[ 21.523751] Call trace:

[ 21.523767] __switch_to+0xe0/0x128

[ 21.523786] event_xdp_redirect+0x8/0x90

[ 21.523816] rcu: INFO: rcu_sched detected stalls on CPUs/tasks:

[ 21.523840] rcu: 1-...0: (50 ticks this GP) idle=652/1/0x4000000000000000 softirq=7/30 fqs=2099

[ 21.523859] rcu: 3-...0: (55 ticks this GP) idle=4fa/1/0x4000000000000000 softirq=5/36 fqs=2099

[ 21.523870] rcu: (detected by 2, t=6302 jiffies, g=-1183, q=1)

[ 21.523887] Task dump for CPU 1:

[ 21.523898] rk-pcie R running task 0 55 2 0x0000002a

[ 21.523915] Call trace:

[ 21.523931] __switch_to+0xe0/0x128

[ 21.523944] 0x43752cfcfe820900

[ 21.523955] Task dump for CPU 3:

[ 21.523965] kworker/u8:0 R running task 0 7 2 0x0000002a

[ 21.523990] Workqueue: events_unbound enable_ptr_key_workfn

[ 21.524004] Call trace:

异常原因:如果系统卡住此log附近,则表明PCIe3.0的PHY工作异常。请依次检查:

- 外部晶振芯片的时钟输入是否异常,如果无时钟或者幅度异常,将导致phy无法锁定。

- 检查

PCIE30_AVDD_0V9和PCIE30_AVDD_1V8电压是否满足要求。 - 检查板级DTS中是否有将PCIe的低速IO进行配置,如有请删除再测试;并参考“低速IO说明”部分了解这些IO的具体使用方式。

- RK3588 pcie30phy 如果只使用其中一个port,另一个port也需要供电,检查是否符合要求。

12.4 PCIe2.0控制器初始化设备系统异常

[ 21.523870] rcu: (detected by 2, t=6302 jiffies, g=-1183, q=1)

[ 21.523887] Task dump for CPU 1:

[ 21.523898] rk-pcie R running task 0 55 2 0x0000002a

[ 21.523915] Call trace:

[ 21.523931] __switch_to+0xe0/0x128

[ 21.523944] 0x43752cfcfe820900

[ 21.523955] Task dump for CPU 3:

[ 21.523965] kworker/u8:0 R running task 0 7 2 0x0000002a

[ 21.523990] Workqueue: events_unbound enable_ptr_key_workfn

[ 21.524004] Call trace:

异常原因:如果系统卡住此log附近,则表明PCIe2.0的PHY工作异常。以RK3568的combphy2_psq这个PHY为例,请依次检查:

- 检查

PCIE30_AVDD_0V9和PCIE30_AVDD_1V8电压是否满足要求。 - 检查板级DTS中是否有将PCIe的低速IO进行配置,如有请删除再测试;并参考“低速IO说明”部分了解这些IO的具体使用方式。

- 修改combphy2_psq的驱动phy-rockchip-naneng-combphy.c,在rockchip_combphy_init函数的末尾增加如下代码,检查PHY内部的一些配置:

val = readl(priv->mmio + (0x27 << 2));

dev_err(priv->dev, "TXPLL_LOCK is 0x%x PWON_PLL is 0x%x\n",

val & BIT(0), val & BIT(1));

val = readl(priv->mmio + (0x28 << 2));

dev_err(priv->dev, "PWON_IREF is 0x%x\n", val & BIT(7));

首先查看TXPLL_LOCK是否为1,如果不是,表明PHY没有lock完成。其次查看PWON_IREF是否为1,如果不为1,则表明PHY时钟异常。此时尝试切换combophy的时钟频率,修改rk3568.dtsi中的combphy2_psq的assigned-clock-rates,依次调整为25M或者100M进行尝试。

如果调整以上步骤均无效,请将PHY内部的时钟bypass到refclk差分信号脚上,进行测量。bypass加在rockchip_combphy_pcie_init函数的末尾,根据芯片的不同,设置如下代码所示:

/* For RK356X, RK3588 */

u32 val;

val = readl(priv->mmio + (0xd << 2));

val |= BIT(5);

writel(val,priv->mmio + (0xd << 2));

/* For RK3528 */

u32 val;

val = readl(priv->mmio + 0x108);

val |= BIT(29);

writel(val, priv->mmio + 0x108);

设置完成后,请依次配置combphy2_psq的时钟频率为24M,25M以及100M,用示波器从PCIe的refclk差分信号脚上测量时钟情况,检查频率和幅值、抖动是否满足要求。

还需特别注意:由于PCIe 2.0接口与SATA2接口复用,如果两者被错误地同时打开,开机过程或者休眠唤醒过程也会出现类似log。

12.5 PCIe外设Memory BAR资源分配异常

外设分配Memory资源异常主要分为三类:

- 地址空间超出平台限制

各平台地址空间大小可查阅常见应用问题章节之“芯片支持分配的BAR空间地址域有多大”。此类异常的典型log如下所示,其特征关键字为no space for,表明21号总线外设向RK平台申请3GB的64bit memory空间,超出了限制导致无法分配资源。若为市售设备,将不受RK芯片支持;若为定制设备,请联系设备vendor确认是否可以修改其BAR空间容量编码。

3.286864] pci 0002:20:00.0: bridge configuration invalid ([bus 01-ff]), reconfiguring

3.286886] scanning [bus 00-00] behind bridge, pass 1

3.288165] pci 0002:21 :00.0: supports D1 D2

3.288170] pci 0002:21 :00.0: PME# supported from DO D1 D3hot

3.298238] pci bus 0002:21: busn res: [bus 21-2f] end is updated to 21

3.298441] pci 0002:21:00.0: BAR 1: no space for [mem size 0xe0000000 ]

3.298456] pci 0002:21:00.0: BAR 1: failed to assign [mem size 0xe0000000 ]

3.298473] pci 0002:21:00.0: BAR 2: assigned [mem 0x380900000- 0x38090ffff pref ]

3.298488] pci 0002:21:00.0: PCI bridge to [bus 21]

- class类型非法

其特征关键字为class 0x000000,且lspci输出可见其BAR资源均显示unassigned状态。应对此问题的正确做法是联系模块供应商,对模块的class类型进行正确的配置。如果无法修改或者作为临时性的解决方案,可以参考所示补丁尝试对模块的class类型进行软件修复,需要填入此异常模块的VID和PID,并且class修复为其真实类型(请参考常见应用问题章节之“在系统中如何确定控制器与设备的对应关系”部分关于class类型的描述进行配置)。

[ 2.335899] pci 0000:02:04.0: [13fe:1730] type 00 class 0x000000

[ 2.335986] pci 0000:02:04.0: reg 0x10: [io 0x0000-0x00ff]

[ 2.336023] pci 0000:02:04.0: reg 0x14: [mem 0x00000000-0x0000007f]

[ 2.336058] pci 0000:02:04.0: reg 0x18: [mem 0x00000000-0x000000ff]

[ 2.342340] pci_bus 0000:02: busn_res: [bus 02-ff] end is updated to 02

[ 2.342444] pci 0000:00:00.0: BAR 8: assigned [mem 0xf4200000-0xf42fffff]

[ 2.342484] pci 0000:00:00.0: BAR 6: assigned [mem 0xf4300000-0xf430ffff pref]

[ 2.342496] pci 0000:00:00.0: BAR 7: assigned [io 0x1000-0x1fff]

[ 2.342510] pci 0000:01:00.0: BAR 8: assigned [mem 0xf4200000-0xf42fffff]

[ 2.342519] pci 0000:01:00.0: BAR 7: assigned [io 0x1000-0x1fff]

[ 2.342529] pci 0000:01:00.0: PCI bridge to [bus 02]

[ 2.342546] pci 0000:01:00.0: bridge window [io 0x1000-0x1fff]

[ 2.342572] pci 0000:01:00.0: bridge window [mem 0xf4200000-0xf42fffff]

[ 2.342616] pci 0000:00:00.0: PCI bridge to [bus 01-ff]

[ 2.342631] pci 0000:00:00.0: bridge window [io 0x1000-0x1fff]

[ 2.342645] pci 0000:00:00.0: bridge window [mem 0xf4200000-0xf42fffff]

[ 2.344896] pcieport 0000:00:00.0: Signaling PME with IRQ 87

lspci -vvv:

0000: 02:04.0 Non-VGA unclassified device: Advantech Co. Ltd Device 1730

Subsystem: Advantech Co. Ltd Device 1730

F1ags: medium devsel, IRQ 255

I/0 ports at[<unassigned> _disabled] [size=256]

Memory at <unass1gned> (3z-bit, non-prefetchabie) [disabled] [size=128]

Memory at <unassigned> (32-bit, non-prefetchable) [disab1ed] [size=256]

--- a/drivers/pci/quirks.c

+++ b/drivers/pci/quirks.c

@@ -207,6 +207,13 @@ static void quirk_mmio_always_on(struct pci_dev *dev)

DECLARE_PCI_FIXUP_CLASS_EARLY(PCI_ANY_ID, PCI_ANY_ID,

PCI_CLASS_BRIDGE_HOST, 8, quirk_mmio_always_on);

+static void quirk_class_id_fixup(struct pci_dev *dev)

+{

+ dev->class = 0x123456; /* Fixup your own class id ! */

+}

+

+DECLARE_PCI_FIXUP_CLASS_EARLY(PCI_VENDOR_ID_FOO, PCI_DEVICE_ID_BAR, 8,

quirk_class_id_fixup); /* Please Add Correct Vendor ID and Device ID ! */

- 外设的BAR寄存器校验异常

其特征关键字为assigned [mem和error updating,且lspci输出可见其BAR资源均显示unassigned状态。出现此问题的原因是外设工作状态异常,导致BAR地址写入外设后,回读校验失败。其可能的因素是低功耗支持异常,或可能是外设对于非Gen1的RC支持存在问题,亦或者是其他类型的模块工作异常。

[ 2.460092] pci 0002:21:00.0: calc_l1ss_pwron: Invalid T_PwrOn scale: 3

[ 2.472049] pci_bus 0002:21: busn_res: [bus 21-2f] end is updated to 21

[ 2.472089] pci 0002:20:00.0: BAR 8: assigned [mem 0xf2200000-0xf23fffff]

[ 2.472105] pci 0002:20:00.0: BAR 6: assigned [mem 0xf2400000-0xf240ffff pref]

[ 2.472124] pci 0002:21:00.0: BAR 0: assigned [mem 0xf2200000-0xf23fffff 64bit]

[ 2.472139] pci 0002:21:00.0: BAR 0: error updating (0xf2200004 != 0xffffffff)

[ 2.472153] pci 0002:21:00.0: BAR 0: error updating (high 0x000000 != 0xffffffff)

此类问题,首先请测量模组供电、#PERST复位信号和100M参考时钟三者的控制时序是否满足模组手册要求,例如QCNFA765模块如果使用常供电方式,就使得时序异常进而导致模块工作异常,产生此问题。如果硬件外围设计与接口时序均满足模块手册要求,则建议依次尝试下列的补丁。若依然无效,联系供应商协助分析模块异常原因。

-

禁止此模块的ASPM功能,其中PID和VID需要填写设备真实的ID。

--- a/drivers/pci/quirks.c

+++ b/drivers/pci/quirks.c

@ -2356,6 +2356,7 @ static void quirk_disable_aspm_l0s_l1(struct pci_dev *dev) *

disable both L0s and L1 for now to be safe.

*/

DECLARE_PCI_FIXUP_FINAL(PCI_VENDOR_ID_ASMEDIA, 0x1080,

quirk_disable_aspm_l0s_l1);

+DECLARE_PCI_FIXUP_FINAL(PID, VID, quirk_disable_aspm_l0s_l1); /* Please Add

Correct Vendor ID and Device ID to disable L0s and L1 ASPM */ -

限制对应控制的模式为Gen1,在dtsi中修改对应节点的

max-link-speed,示例如下:--- a/arch/arm64/boot/dts/rockchip/rk3588s.dtsi

+++ b/arch/arm64/boot/dts/rockchip/rk3588s.dtsi

@@ -4552,7 +4552,7 @@

num-ib-windows = <8>;

num-ob-windows = <8>;

num-viewport = <4>;

- max-link-speed = <2>;

+ max-link-speed = <1>;

msi-map = <0x4000 &its0 0x4000 0x1000>;

num-lanes = <1>;

phys = <&combphy0_ps PHY_TYPE_PCIE>; -

增加外设供电稳定时间以及

#PERST复位时间,示例如下:--- a/arch/arm64/boot/dts/rockchip/rk3568-evb1-lp4.dtsi

+++ b/arch/arm64/boot/dts/rockchip/rk3568-evb1-lp4.dtsi

@@ -159,7 +159,7 @@

regulator-max-microvolt = <3300000>;

enable-active-high;

gpios = <&gpio3 RK_PC3 GPIO_ACTIVE_HIGH>;

- startup-delay-us = <5000>;

+ startup-delay-us = <500000>;

vin-supply = <&vcc12v_dcin>;

}; /* vcc3v3_pcie30 */

@@ -551,6 +551,7 @@

&pcie3x4 {

reset-gpios = <&gpio4 RK_PB6 GPIO_ACTIVE_HIGH>;

vpcie3v3-supply = <&vcc3v3_pcie30>;

+ rockchip,perst-inactive-ms = <1000>;

status = "okay";

}; -

已知高通部分系列的wifi模块存在异常,受影响的模块包AR9xxx系列和QCA9xxx系列。非高通系列模块无需此补丁。

--- a/drivers/pci/pcie/aspm.c

+++ b/drivers/pci/pcie/aspm.c

@@ -192,12 +192,56 @@ static void pcie_clkpm_cap_init(struct pcie_link_state

*link, int blacklist)

link->clkpm_disable = blacklist ? 1 : 0;

}

+static int pcie_downgrade_link_to_gen1(struct pci_dev *parent)

+{

+ u16 reg16;

+ u32 reg32;

+ int ret;

+

+ /* Check if link is capable of higher speed than 2.5 GT/s */

+ pcie_capability_read_dword(parent, PCI_EXP_LNKCAP, ®32);

+ if ((reg32 & PCI_EXP_LNKCAP_SLS) <= PCI_EXP_LNKCAP_SLS_2_5GB)

+ return 0;

+

+ /* Check if link speed can be downgraded to 2.5 GT/s */

+ pcie_capability_read_dword(parent, PCI_EXP_LNKCAP2, ®32);

+ if (!(reg32 & PCI_EXP_LNKCAP2_SLS_2_5GB)) {

+ pci_err(parent, "ASPM: Bridge does not support changing Link Speed to 2.5

GT/s\n");

+ return -EOPNOTSUPP;

+ }

+

+ /* Force link speed to 2.5 GT/s */

+ ret = pcie_capability_clear_and_set_word(parent, PCI_EXP_LNKCTL2,

+ PCI_EXP_LNKCTL2_TLS,

+ PCI_EXP_LNKCTL2_TLS_2_5GT);

+ if (!ret) {

+ /* Verify that new value was really set */

+ pcie_capability_read_word(parent, PCI_EXP_LNKCTL2, ®16);

+ if ((reg16 & PCI_EXP_LNKCTL2_TLS) != PCI_EXP_LNKCTL2_TLS_2_5GT)

+ ret = -EINVAL;

+ }

+

+ if (ret) {

+ pci_err(parent, "ASPM: Changing Target Link Speed to 2.5 GT/s failed:

%d\n", ret);

+ return ret;

+ }

+

+ pci_info(parent, "ASPM: Target Link Speed changed to 2.5 GT/s due to

quirk\n");

+ return 0;

+}

+

static bool pcie_retrain_link(struct pcie_link_state *link)

{

struct pci_dev *parent = link->pdev;

unsigned long end_jiffies;

u16 reg16;

+ if ((link->downstream->dev_flags &

PCI_DEV_FLAGS_NO_RETRAIN_LINK_WHEN_NOT_GEN1) &&

+ pcie_downgrade_link_to_gen1(parent)) {

+ pci_err(parent, "ASPM: Retrain Link at higher speed is disallowed by

quirk\n");

+ return false;

+ }

+

pcie_capability_read_word(parent, PCI_EXP_LNKCTL, ®16);

reg16 |= PCI_EXP_LNKCTL_RL;

pcie_capability_write_word(parent, PCI_EXP_LNKCTL, reg16);

diff --git a/drivers/pci/quirks.c b/drivers/pci/quirks.c

index 653660e3ba9e..4999ad9d08b8 100644

--- a/drivers/pci/quirks.c

+++ b/drivers/pci/quirks.c

@@ -3553,23 +3553,46 @@ static void mellanox_check_broken_intx_masking(struct

pci_dev *pdev)

DECLARE_PCI_FIXUP_FINAL(PCI_VENDOR_ID_MELLANOX, PCI_ANY_ID,

mellanox_check_broken_intx_masking);

-static void quirk_no_bus_reset(struct pci_dev *dev)

+static void quirk_no_bus_reset_and_no_retrain_link(struct pci_dev *dev)

{

- dev->dev_flags |= PCI_DEV_FLAGS_NO_BUS_RESET;

+ dev->dev_flags |= PCI_DEV_FLAGS_NO_BUS_RESET |

+ PCI_DEV_FLAGS_NO_RETRAIN_LINK_WHEN_NOT_GEN1;

}

/*

- * Some Atheros AR9xxx and QCA988x chips do not behave after a bus reset.

+ * Atheros AR9xxx and QCA9xxx chips do not behave after a bus reset and also

+ * after retrain link when PCIe bridge is not in GEN1 mode at 2.5 GT/s speed.

* The device will throw a Link Down error on AER-capable systems and

* regardless of AER, config space of the device is never accessible again

* and typically causes the system to hang or reset when access is attempted.

+ * Or if config space is accessible again then it contains only dummy values

+ * like fixed PCI device ID 0xABCD or values not initialized at all.

+ * Retrain link can be called only when using GEN1 PCIe bridge or when

+ * PCIe bridge has forced link speed to 2.5 GT/s via PCI_EXP_LNKCTL2 register.

+ * To reset these cards it is required to do PCIe Warm Reset via PERST# pin.

* https://lore.kernel.org/r/20140923210318.498dacbd@dualc.maya.org/

+ * https://lore.kernel.org/r/87h7l8axqp.fsf@toke.dk/

+ * https://www.mail-archive.com/ath9k-devel@lists.ath9k.org/msg07529.html

*/

-DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x0030, quirk_no_bus_reset);

-DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x0032, quirk_no_bus_reset);

-DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x003c, quirk_no_bus_reset);

-DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x0033, quirk_no_bus_reset);

-DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x0034, quirk_no_bus_reset);

+DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x002e,

+ quirk_no_bus_reset_and_no_retrain_link);

+DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x0030,

+ quirk_no_bus_reset_and_no_retrain_link);

+DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x0032,

+ quirk_no_bus_reset_and_no_retrain_link);

+DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x0033,

+ quirk_no_bus_reset_and_no_retrain_link);

+DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x0034,

+ quirk_no_bus_reset_and_no_retrain_link);

+DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x003c,

+ quirk_no_bus_reset_and_no_retrain_link);

+DECLARE_PCI_FIXUP_HEADER(PCI_VENDOR_ID_ATHEROS, 0x0042,

+ quirk_no_bus_reset_and_no_retrain_link);

+

+static void quirk_no_bus_reset(struct pci_dev *dev)

+{

+ dev->dev_flags |= PCI_DEV_FLAGS_NO_BUS_RESET;

+}

/*

* Root port on some Cavium CN8xxx chips do not successfully complete a bus

diff --git a/include/linux/pci.h b/include/linux/pci.h

index 86c799c97b77..fdbf7254e4ab 100644

--- a/include/linux/pci.h

+++ b/include/linux/pci.h

@@ -227,6 +227,8 @@ enum pci_dev_flags {

PCI_DEV_FLAGS_NO_FLR_RESET = (__force pci_dev_flags_t) (1 << 10),

/* Don't use Relaxed Ordering for TLPs directed at this device */

PCI_DEV_FLAGS_NO_RELAXED_ORDERING = (__force pci_dev_flags_t) (1 << 11),

/* Device does honor MSI masking despite saying otherwise */

PCI_DEV_FLAGS_HAS_MSI_MASKING = (__force pci_dev_flags_t) (1 << 12),